Respuestas ejercicios

Eliana Jung1

Este capítulo ofrece una guía de respuestas para los ejercicios de los capítulos anteriores. En general, no hay una sola forma de resolver los ejercicios, por lo que lo siguiente debe tomarse como una guía para que compares y autoevalúes tus respuestas.

Si eres profesor(a) y piensas utilizar el libro en tu curso de métodos, te sugerimos usar esto como una guía de preguntas y respuestas, pero incluir también otros ejercicios.

Capítulo 1: R Básico

Paquetes: tidyverse y paqueteadp

library(tidyverse)

library(remotes)

library(readr)

library(paqueteadp)Ejercicio 1B

vector_salarios <- c(462.3, 431.7, 394, 355.6, 298, 297.9, 275.7, 257.3, 254.7, 156.9, 7)

mean(vector_salarios)

## [1] 29016.5.3.1 Ejercicio 1C

## install.packages("ggparliament")

library(ggparliament)Capítulo 2: Manejo de datos

Paquetes y carga de datos

library(tidyverse)

library(paqueteadp)

## install.packages("skimr")

library(skimr)

data("aprobacion") Ejercicio 2A

Seleccione sólo las dos columnas que registran el género del presidente en la base de datos.

select(aprobacion, presidente, presidente_genero)

## # A tibble: 1,020 x 2

## presidente presidente_genero

## <chr> <chr>

## 1 Fernando de la Rúa Masculino

## 2 Fernando de la Rúa Masculino

## 3 Fernando de la Rúa Masculino

## # ... with 1,017 more rowsEjercicio 2B

Filtrar los datos para que contengan sólo observaciones del año 2000.

filter(aprobacion, anio == 2000)

## # A tibble: 68 x 11

## pais anio trimestre presidente presidente_gene~ aprobacion_neta pib

## <chr> <dbl> <dbl> <chr> <chr> <dbl> <dbl>

## 1 Arge~ 2000 1 Fernando ~ Masculino 40.1 14.0

## 2 Arge~ 2000 2 Fernando ~ Masculino 16.4 14.0

## 3 Arge~ 2000 3 Fernando ~ Masculino 24.0 14.0

## # ... with 65 more rows, and 4 more variablesEjercicio 2C

Crear una nueva base, que está ordenada por país-trimestre del año con menos aprobación presidencial al de más alto nivel (recuerde crear un nuevo objeto y darle un nombre descriptivo). En tu nuevo objeto, conserva sólo las observaciones con mujeres como presidentas.

aprobacion_presidentas <- aprobacion %>%

filter(presidente_genero == "Femenino") %>%

arrange(pais, trimestre, aprobacion_neta)

head(aprobacion_presidentas, n = 20)

## # A tibble: 20 x 11

## pais anio trimestre presidente presidente_gene~ aprobacion_neta pib

## <chr> <dbl> <dbl> <chr> <chr> <dbl> <dbl>

## 1 Arge~ 2010 1 Cristina ~ Femenino -18.5 52.4

## 2 Arge~ 2014 1 Cristina ~ Femenino -6.77 52.4

## 3 Arge~ 2009 1 Cristina ~ Femenino -5.64 50.1

## # ... with 17 more rows, and 4 more variablesEjercicio 2D

Crear una nueva variable, que registre el desempleo como proporción en lugar de como porcentaje.

aprobacion %>%

mutate(desempleo_proporcion = desempleo/100) %>%

select(pais, anio, trimestre, presidente, desempleo, desempleo_proporcion)

## # A tibble: 1,020 x 6

## pais anio trimestre presidente desempleo desempleo_proporci~

## <chr> <dbl> <dbl> <chr> <dbl> <dbl>

## 1 Argenti~ 2000 1 Fernando de la ~ 15 0.15

## 2 Argenti~ 2000 2 Fernando de la ~ 15 0.15

## 3 Argenti~ 2000 3 Fernando de la ~ 15 0.15

## # ... with 1,017 more rowsEjercicio 2E

Calcular, con la ayuda de los

pipes, la corrupción del ejecutivo medio y el PIB por país. Recuerde que puede insertarpipesconCtrloCmd+Shift+M.

aprobacion %>%

group_by(pais) %>%

summarize(promedio_corrupcion = mean(corrupcion),

promedio_pib = mean(pib))

## # A tibble: 17 x 3

## pais promedio_corrupcion promedio_pib

## <chr> <dbl> <dbl>

## 1 Argentina 671977296126. 44.4

## 2 Bolivia 48568023767. 46.1

## 3 Brasil 2540610234933. 31.4

## # ... with 14 more rowsEjercicio 2F

Una vez más, utilizando

pipes, clasifique los países de la base de datos desde el que obtuvo el mayor promedio de PIB per cápita en el período 2010-2014 hasta el más bajo.

aprobacion %>%

filter(anio >= 2010 & anio <= 2014) %>%

group_by(pais) %>%

summarize(promedio_pib = mean(pib)) %>%

arrange(-promedio_pib)

## # A tibble: 17 x 2

## pais promedio_pib

## <chr> <dbl>

## 1 Venezuela 86.6

## 2 Honduras 78.6

## 3 Guatemala 76.4

## # ... with 14 more rowsEjercicio 2G

¿Qué trimestre del año, entre los gobernados por mujeres presidenteas, tuvo la corrupción más alta? ¿Y la mayor aprobación neta?

aprobacion %>%

filter(presidente_genero == "Femenino") %>%

arrange(-corrupcion) %>%

select(pais, anio, trimestre, presidente, corrupcion)

## # A tibble: 98 x 5

## pais anio trimestre presidente corrupcion

## <chr> <dbl> <dbl> <chr> <dbl>

## 1 Brasil 2014 1 Dilma Vana Rousseff 3.14e12

## 2 Brasil 2014 2 Dilma Vana Rousseff 3.14e12

## 3 Brasil 2014 3 Dilma Vana Rousseff 3.14e12

## # ... with 95 more rows

aprobacion %>%

filter(presidente_genero == "Femenino") %>%

arrange(-aprobacion_neta) %>%

select(pais, anio, trimestre, presidente, aprobacion_neta)

## # A tibble: 98 x 5

## pais anio trimestre presidente aprobacion_neta

## <chr> <dbl> <dbl> <chr> <dbl>

## 1 Brasil 2013 1 Dilma Vana Rousseff 62.5

## 2 Brasil 2012 4 Dilma Vana Rousseff 60.9

## 3 Brasil 2012 2 Dilma Vana Rousseff 60.5

## # ... with 95 more rowsEjercicio 2H

if_else()puede ser pensado como una versión reducida decase_when(): todo lo que hacemos con la primera función podría ser convertido en la sintaxis de la segunda. Traduzca uno de los ejemplos anteriores conif_else()a la sintaxiscase_when()}

aprobacion %>%

mutate(d_pres_mujer = case_when(presidente_genero == "Femenino" ~ 1,

presidente_genero != "Femenino" ~ 0))%>%

select(pais:presidente, presidente_genero, d_pres_mujer)

## # A tibble: 1,020 x 6

## pais anio trimestre presidente presidente_gene~ d_pres_mujer

## <chr> <dbl> <dbl> <chr> <chr> <dbl>

## 1 Argenti~ 2000 1 Fernando de la ~ Masculino 0

## 2 Argenti~ 2000 2 Fernando de la ~ Masculino 0

## 3 Argenti~ 2000 3 Fernando de la ~ Masculino 0

## # ... with 1,017 more rows

aprobacion %>%

mutate(d_crisis_ec = case_when(crecimiento_pib < 0 | desempleo > 20 ~ 1,

TRUE ~ 0)) %>%

select(pais:trimestre, crecimiento_pib, desempleo, d_crisis_ec) %>%

filter(pais == "Argentina" & anio %in% c(2001, 2013))

## # A tibble: 8 x 6

## pais anio trimestre crecimiento_pib desempleo d_crisis_ec

## <chr> <dbl> <dbl> <dbl> <dbl> <dbl>

## 1 Argentina 2001 1 -4.4 18.3 1

## 2 Argentina 2001 2 -4.4 18.3 1

## 3 Argentina 2001 3 -4.4 18.3 1

## # ... with 5 more rowsEjercicio 2I

Crea una nueva variable que separa los países en tres grupos: “América del Norte,” “América Central” y “América del Sur.”

unique(aprobacion$pais) # Para ver los países y evitar posibles errores de tipeo/escritura

## [1] "Argentina" "Bolivia" "Brasil" "Chile"

## [5] "Colombia" "Costa Rica" "Ecuador" "El Salvador"

## [9] "Guatemala" "Honduras" "México" "Nicaragua"

## [13] "Panamá" "Paraguay" "Perú" "Uruguay"

## [17] "Venezuela"16.5.3.1.0.1 Alternativa 1

aprobacion %>%

mutate(region = case_when(pais == "México" ~ "América del Norte",

pais %in% c("Costa Rica",

"El Salvador",

"Guatemala",

"Honduras",

"Nicaragua",

"Panamá") ~ "América Central",

pais %in% c("Argentina", "Bolivia",

"Brasil",

"Chile",

"Colombia",

"Ecuador",

"Paraguay",

"Perú",

"Uruguay",

"Venezuela") ~ "América del Sur")) %>%

select(pais:presidente,region)

## # A tibble: 1,020 x 5

## pais anio trimestre presidente region

## <chr> <dbl> <dbl> <chr> <chr>

## 1 Argentina 2000 1 Fernando de la Rúa América del Sur

## 2 Argentina 2000 2 Fernando de la Rúa América del Sur

## 3 Argentina 2000 3 Fernando de la Rúa América del Sur

## # ... with 1,017 more rows16.5.3.1.0.2 Alternativa 2

aprobacion %>%

mutate(region = case_when(pais == "México" ~ "América del Norte",

pais %in% c("Costa Rica",

"El Salvador",

"Guatemala",

"Honduras",

"Nicaragua",

"Panamá") ~ "América Central",

TRUE ~ "América del Sur")) %>%

select(pais:presidente,region)

## # A tibble: 1,020 x 5

## pais anio trimestre presidente region

## <chr> <dbl> <dbl> <chr> <chr>

## 1 Argentina 2000 1 Fernando de la Rúa América del Sur

## 2 Argentina 2000 2 Fernando de la Rúa América del Sur

## 3 Argentina 2000 3 Fernando de la Rúa América del Sur

## # ... with 1,017 more rowsEjercicio 2J

Genera una base en formato tidy con el crecimiento medio del PIB por país-año. Convierte estos datos a un formato ancho/wide, moviendo los años a las columnas

aprobacion_pib <- aprobacion %>%

group_by(pais, anio) %>%

summarize(crecimiento_pib_promedio = mean(crecimiento_pib))

aprobacion_pib

## # A tibble: 255 x 3

## # Groups: pais [17]

## pais anio crecimiento_pib_promedio

## <chr> <dbl> <dbl>

## 1 Argentina 2000 -0.8

## 2 Argentina 2001 -4.4

## 3 Argentina 2002 -10.9

## # ... with 252 more rows

aprobacion_pib_wide <- aprobacion_pib %>%

pivot_wider(names_from = "anio", values_from = "crecimiento_pib_promedio")

aprobacion_pib_wide

## # A tibble: 17 x 16

## # Groups: pais [17]

## pais `2000` `2001` `2002` `2003` `2004` `2005` `2006` `2007` `2008`

## <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

## 1 Arge~ -0.8 -4.4 -10.9 8.8 9 8.9 8 9 4.1

## 2 Boli~ 2.51 1.68 2.49 2.71 4.17 4.42 4.80 4.56 6.15

## 3 Bras~ 4.4 1.4 3.1 1.1 5.8 3.2 4 6.1 5.1

## # ... with 14 more rows, and 6 more variablesCapítulo 3: Visualización de datos

Paquetes y carga de datos

library(tidyverse)

library(paqueteadp)

## install.packages("ggrepel")

library(ggrepel)

data("datos_municipales")Ejercicio 3A

Te invitamos a jugar con

geom_text(): cambiar los colores, el tamaño, las fuentes, etcétera.También te animamos a instalar paquetes que te permitan personalizar aún más tus gráficos:

ggthemesde jrnorl tiene temas para gráficos de programas y revistas conocidas como Excel o The Economist. Por otro lado,hrbrthemesde hrbrmstr ha elaborado algunos temas minimalistas y elegantes que harán que todos tus gráficos se vean mejor. Si te gustan los colores, puedes consultar el paquetewespalettede karthik, una paleta cromática basada en las películas de Wes Anderson, o crear tus propias paletas basadas en imágenes concolorfindr. Puedes encontrar más sobre esto último en el siguiente link.

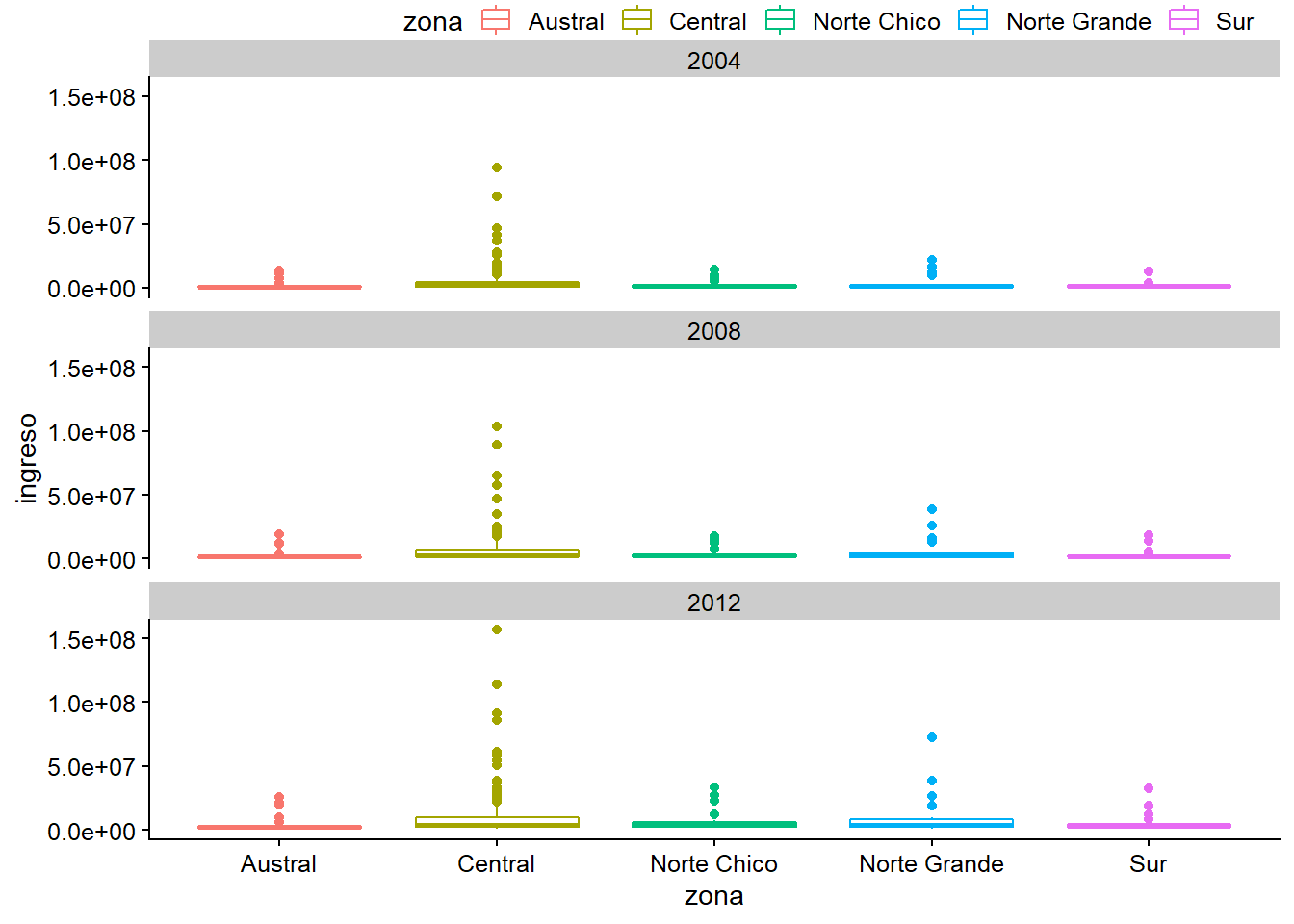

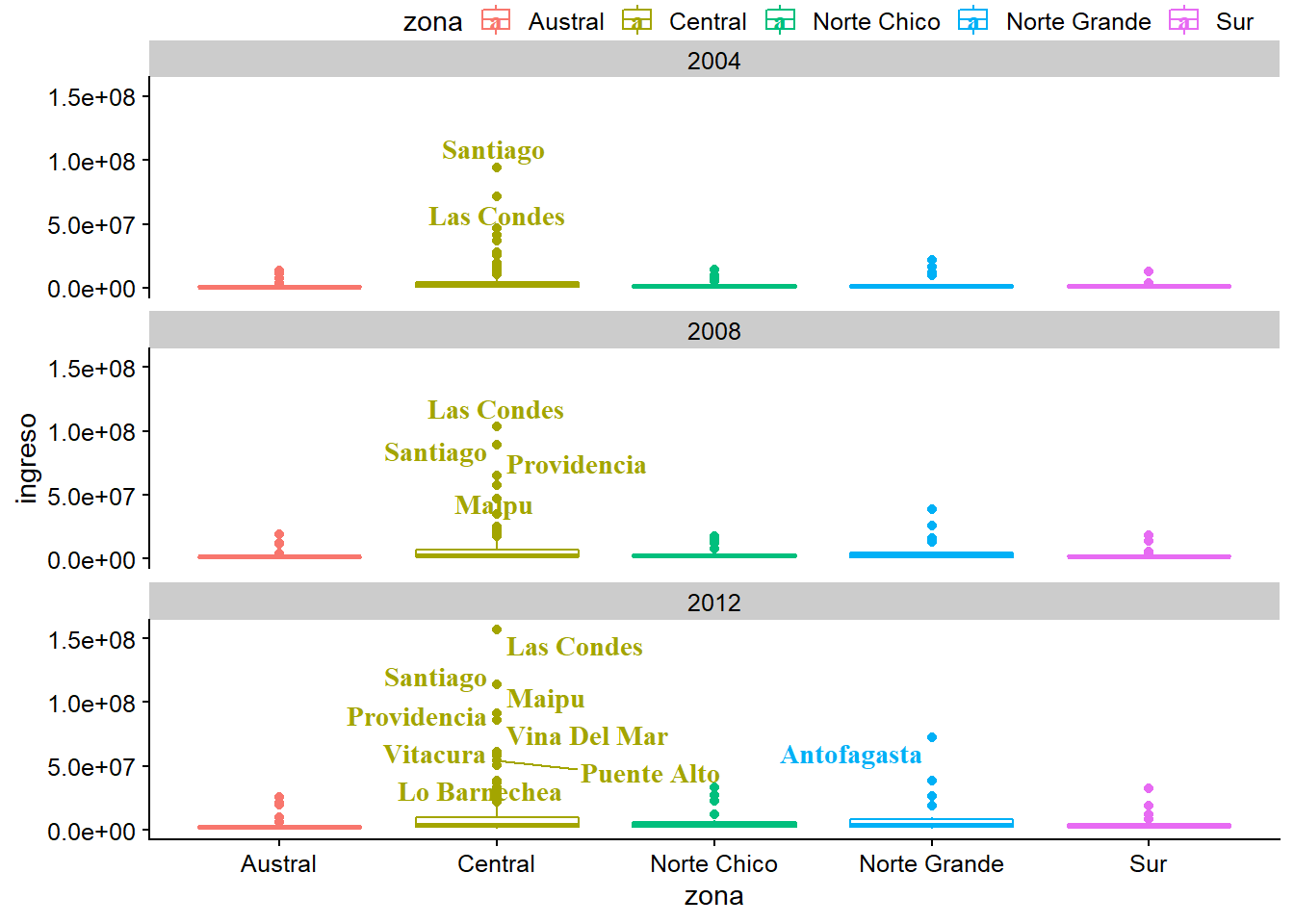

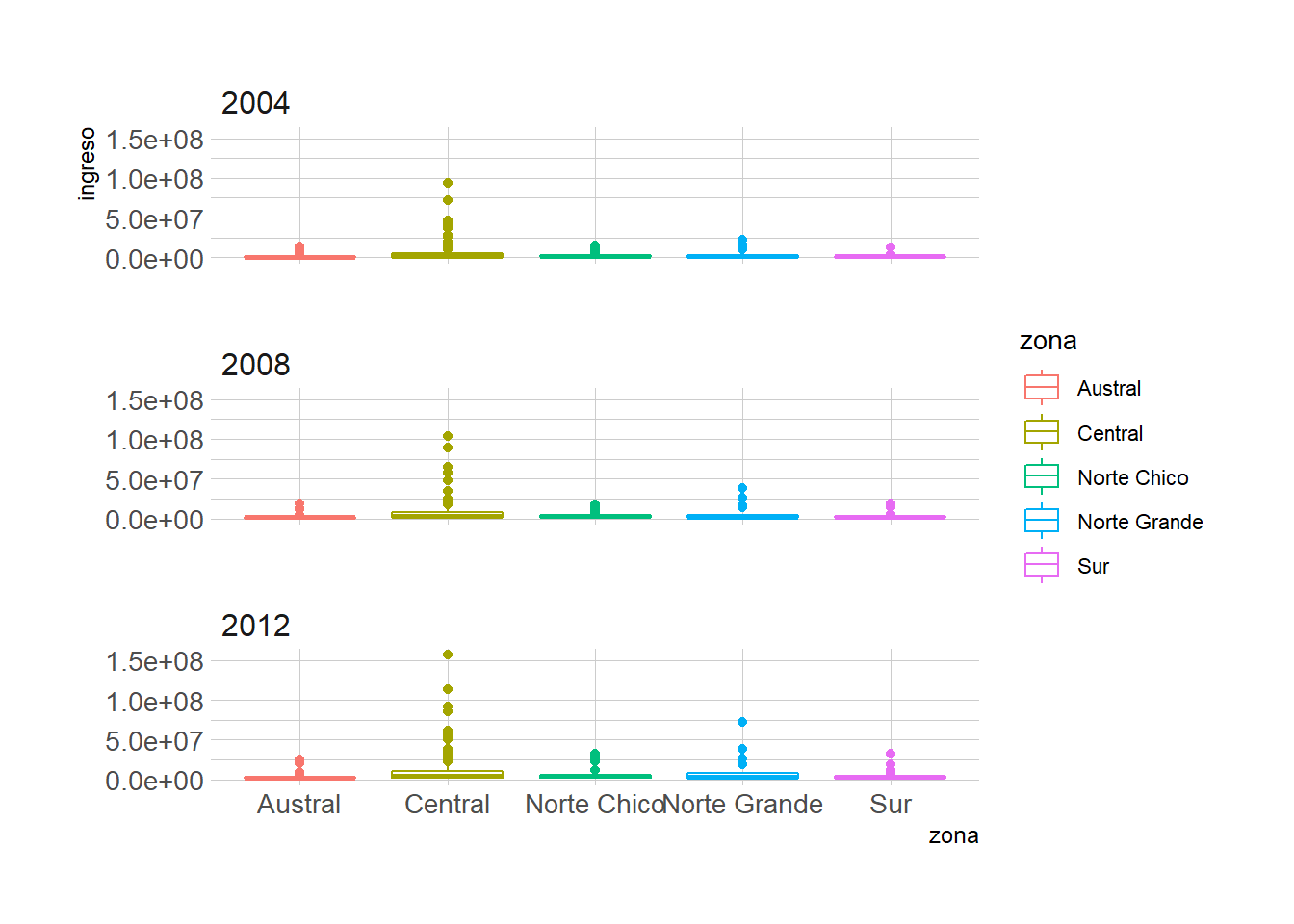

Gráfico original

plot_c <- ggplot(data = datos_municipales %>%

filter(anio %in% c(2004, 2008, 2012)),

mapping = aes(x = zona, y = ingreso, color = zona)) +

geom_boxplot() +

facet_wrap(~anio, ncol = 1)

plot_c

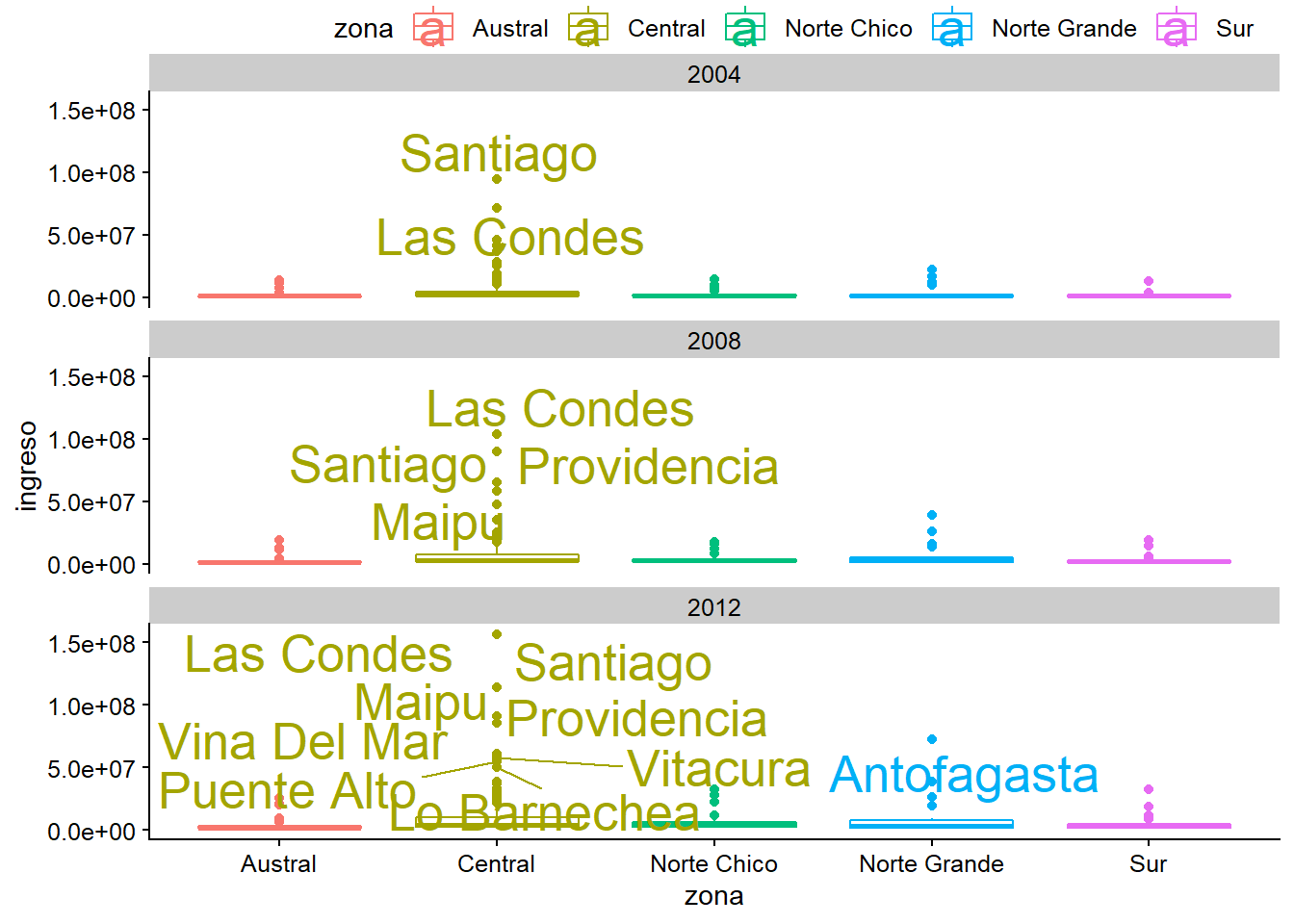

Cambiar el tamaño al texto

plot_c +

geom_text_repel(data = datos_municipales %>%

filter(ingreso > 50000000),

mapping = aes(label = municipalidad),

size = 7)

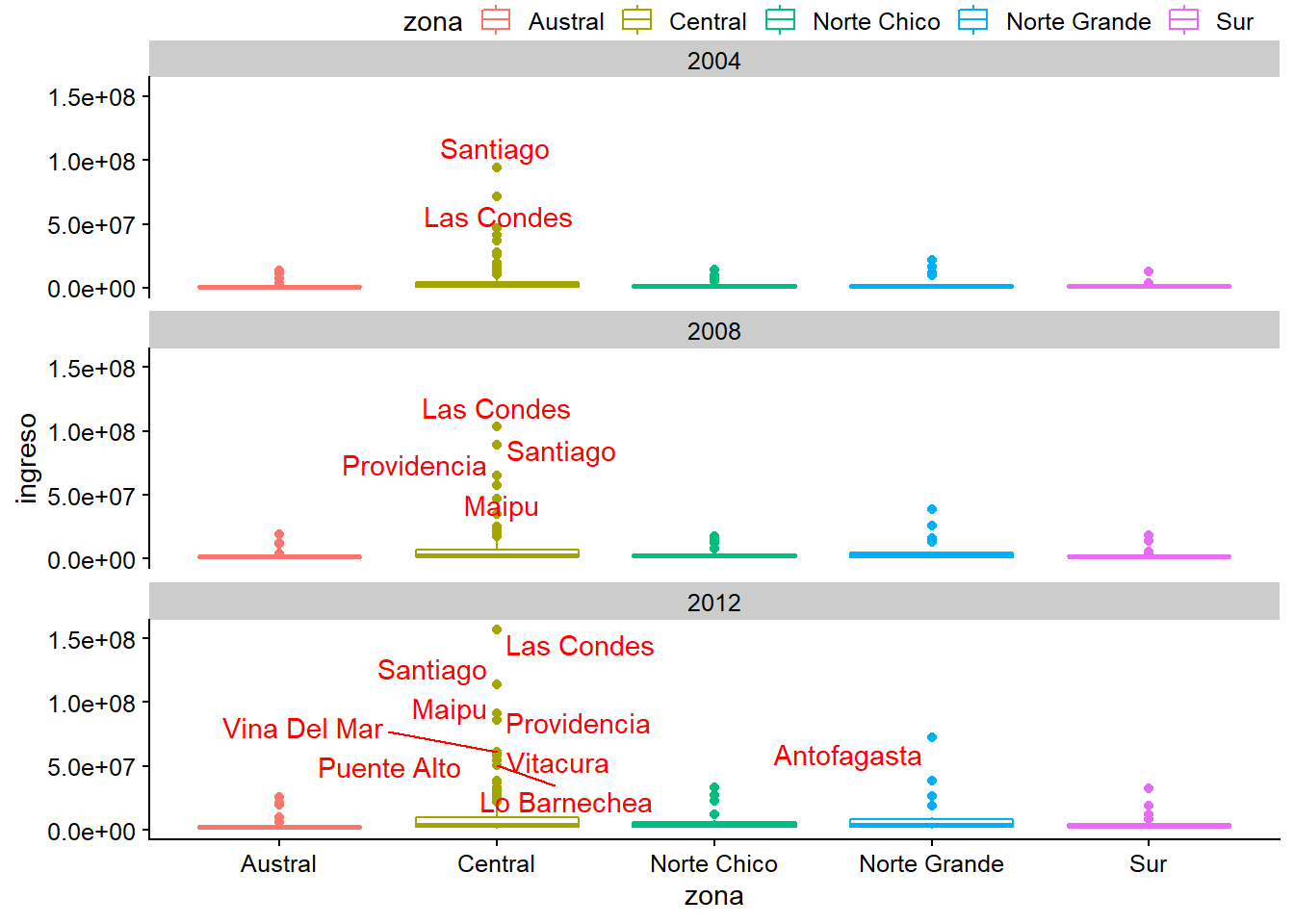

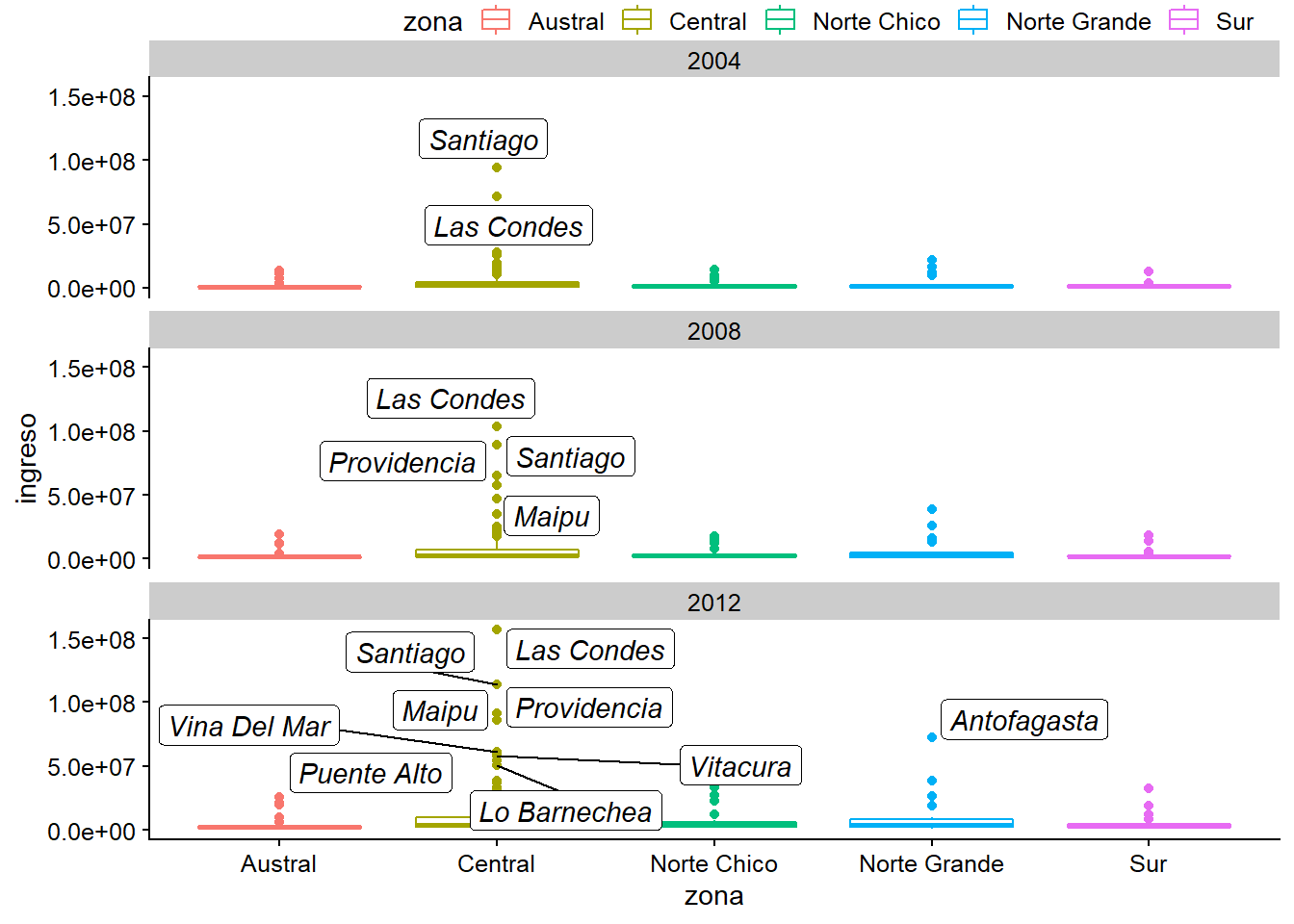

Cambiar el color al texto

plot_c +

geom_text_repel(data = datos_municipales %>%

filter(ingreso > 50000000),

mapping = aes(label = municipalidad),

colour = "red")

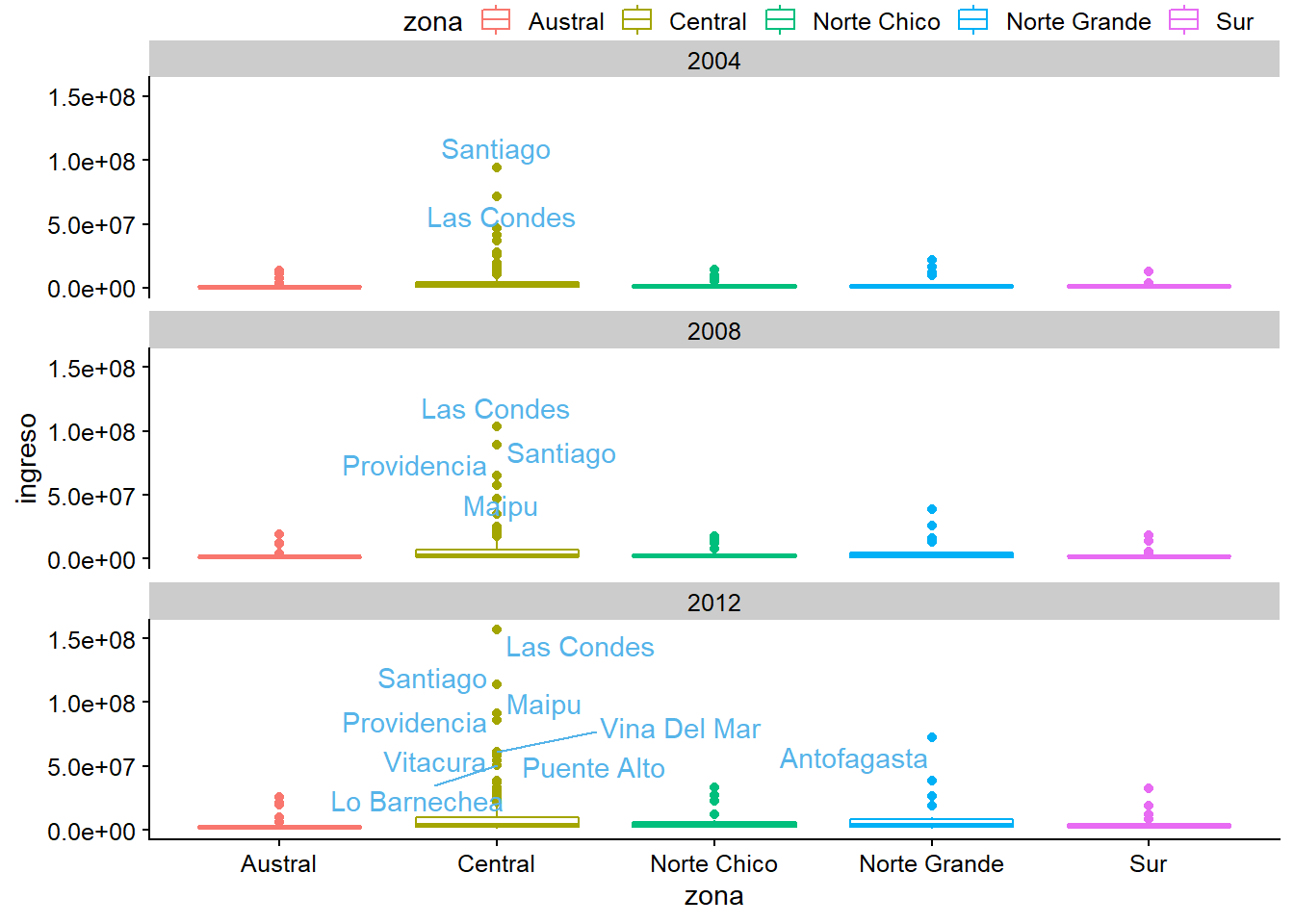

plot_c +

geom_text_repel(data = datos_municipales %>%

filter(ingreso > 50000000),

mapping = aes(label = municipalidad),

colour = "#56B4E9")

Cambiar la fuente y el tipo de letra

plot_c +

geom_text_repel(data = datos_municipales %>%

filter(ingreso > 50000000),

mapping = aes(label = municipalidad),

family = "serif",

fontface = "bold")

Cambiar el tipo de etiqueta con geom_label_repel

plot_c +

geom_label_repel(data = datos_municipales %>%

filter(ingreso > 50000000),

mapping = aes(label = municipalidad),

colour = "black",

fontface = "italic")

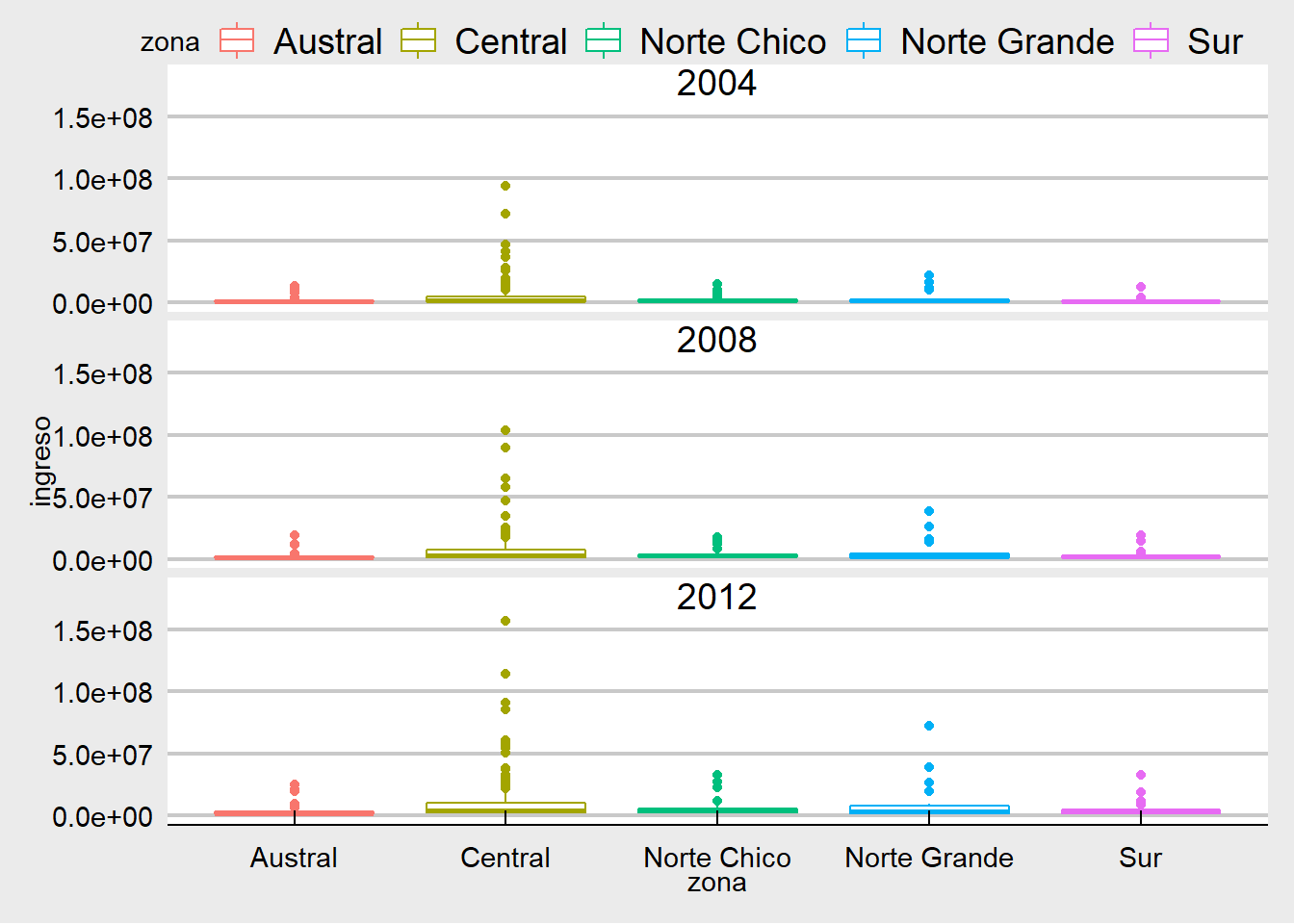

Otros paquetes: ggthemes y hrbrthemes

## install.packages("ggthemes")

## install.packages("hrbrthemes")

library(ggthemes)

library(hrbrthemes)ggthemes

plot_c +

theme_economist_white()

plot_c +

theme_solarized()

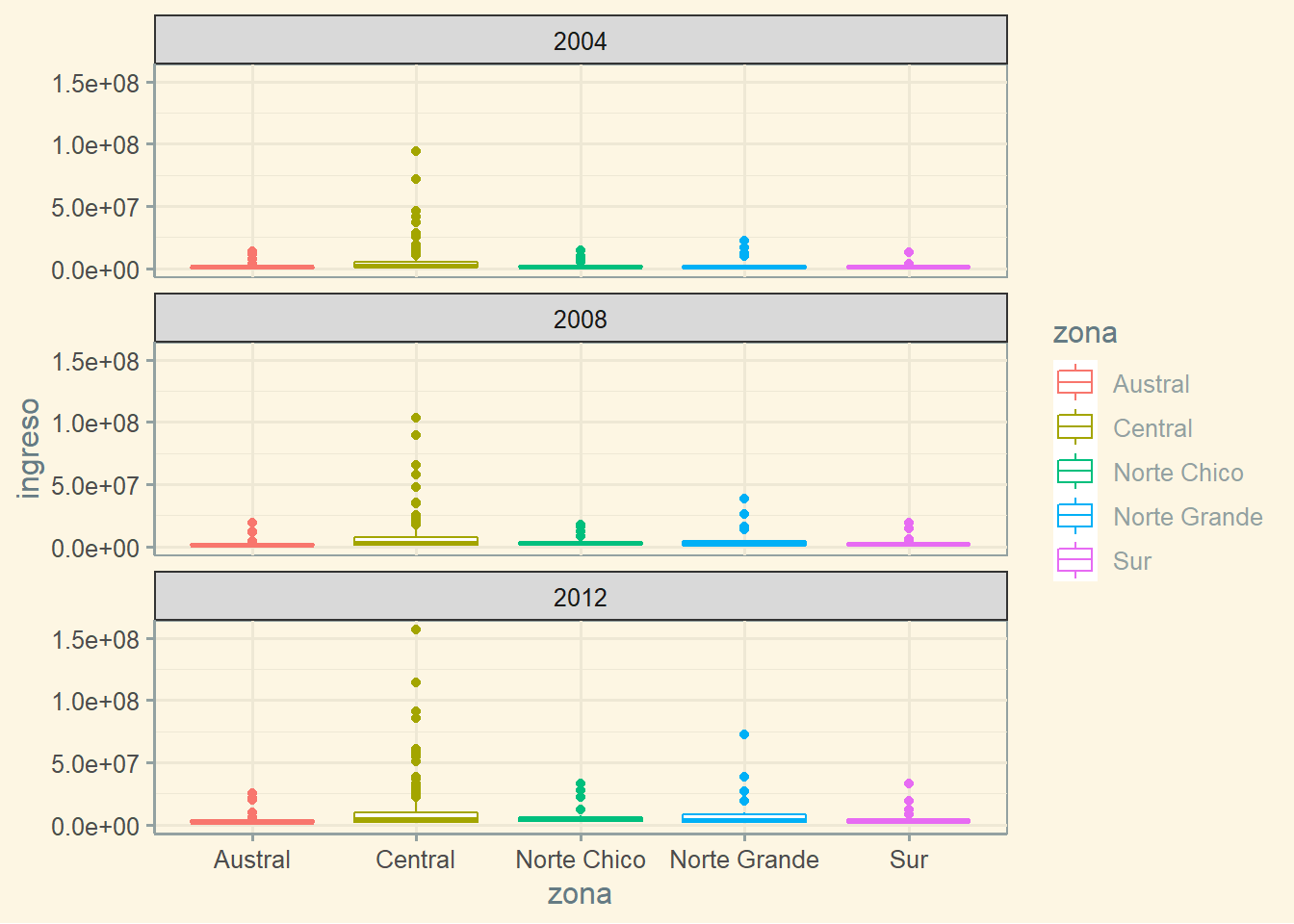

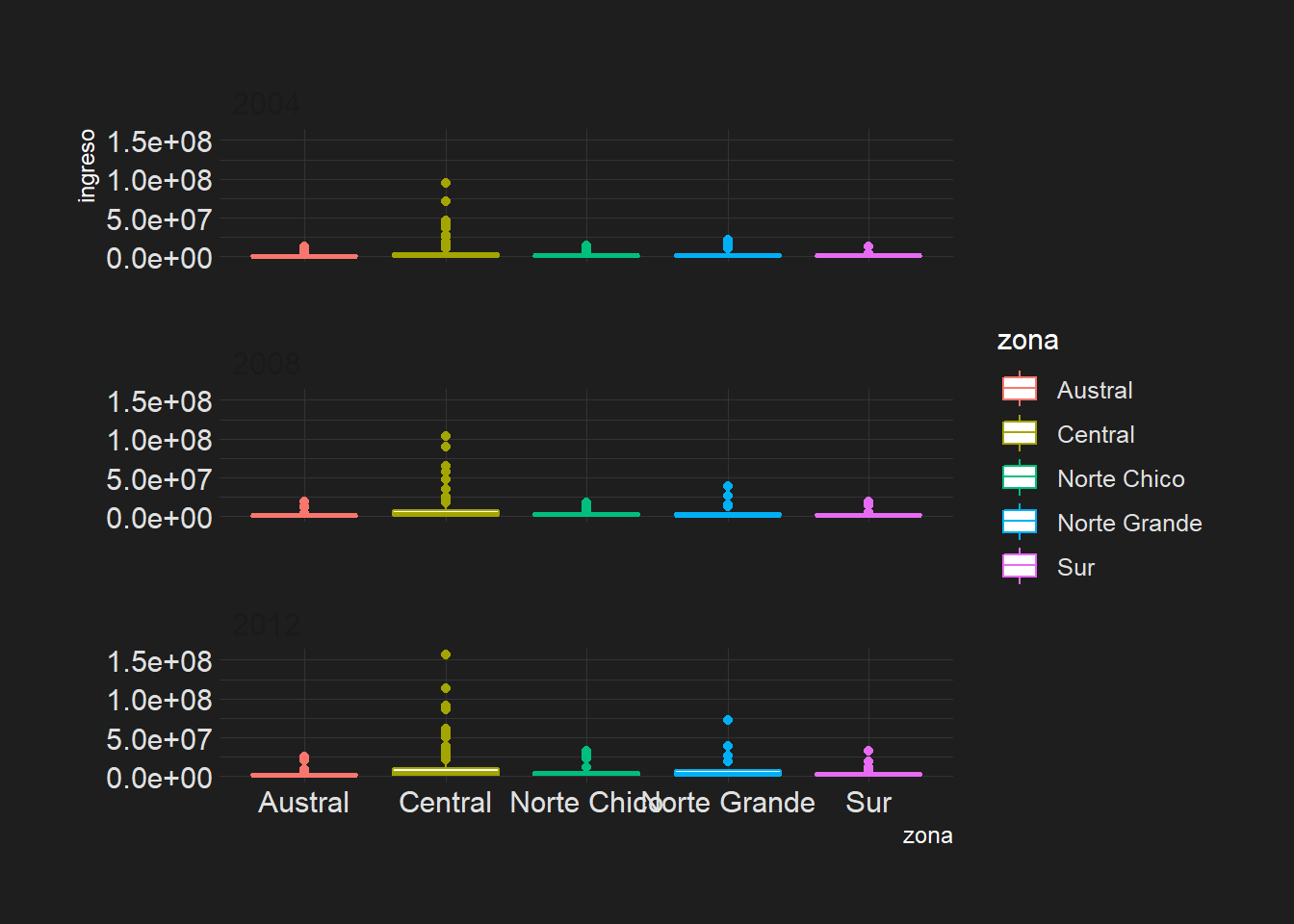

hrbrthemes

plot_c +

theme_tinyhand()

plot_c +

theme_modern_rc()

Ejercicio 3B

¿Qué pasa si ponemos bins = 15 de intervalos?

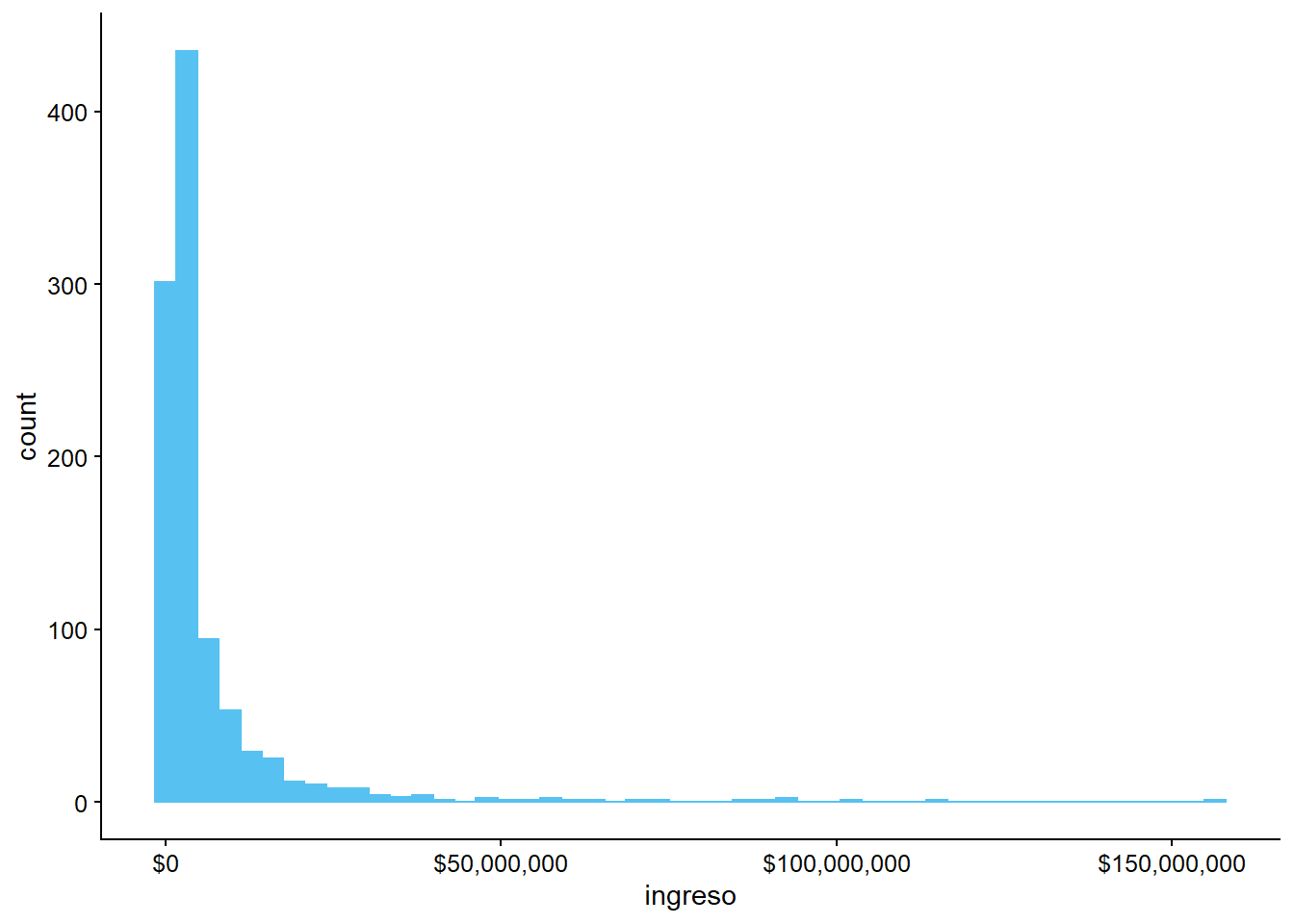

Gráfico original

ggplot(data = datos_municipales,

mapping = aes(x = ingreso)) +

geom_histogram(bins = 50) +

scale_x_continuous(labels = scales::dollar)

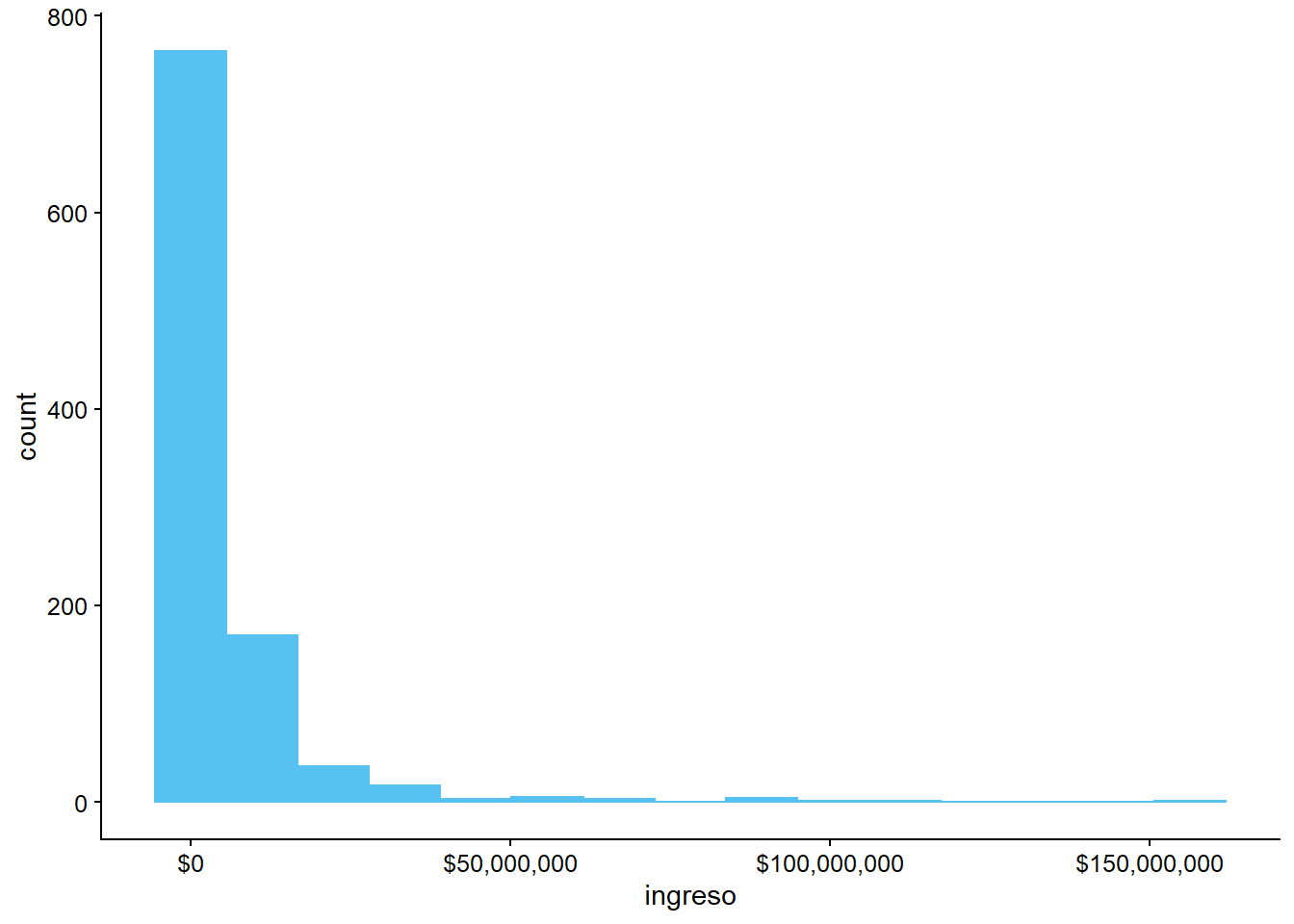

Cambiar tamaño de barras

ggplot(data = datos_municipales,

mapping = aes(x = ingreso)) +

geom_histogram(bins = 15) +

scale_x_continuous(labels = scales::dollar)

Ejercicio 3C

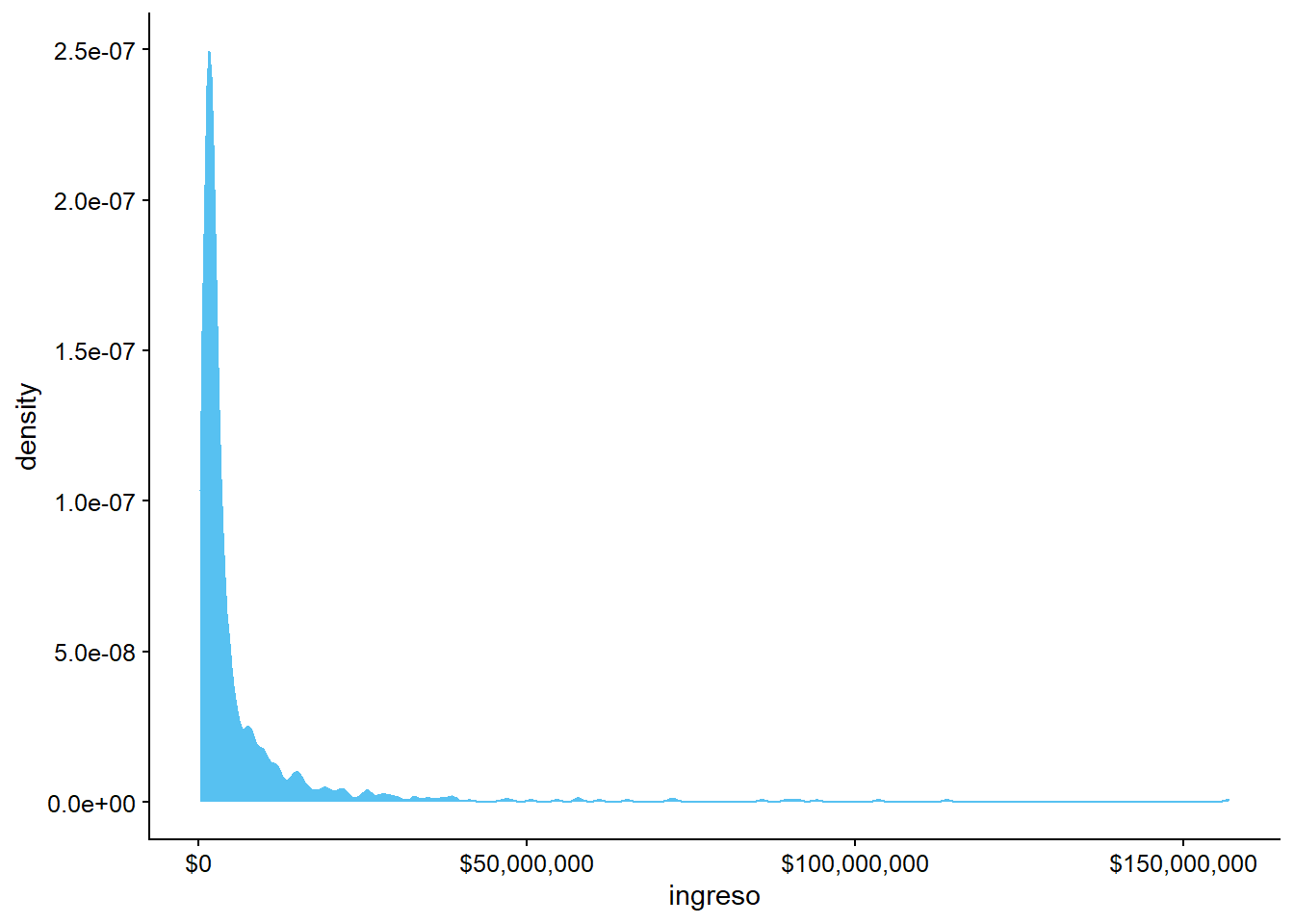

Ya hemos aprendido a hacer un histograma, sin embargo, los gráficos de densidad tienden a ser más utilizados para mirar la distribución de una variable. Usando las mismas variables, haz una gráfica de densidad con

geom_density()

ggplot(data = datos_municipales,

mapping = aes(x = ingreso)) +

geom_density() +

scale_x_continuous(labels = scales::dollar)

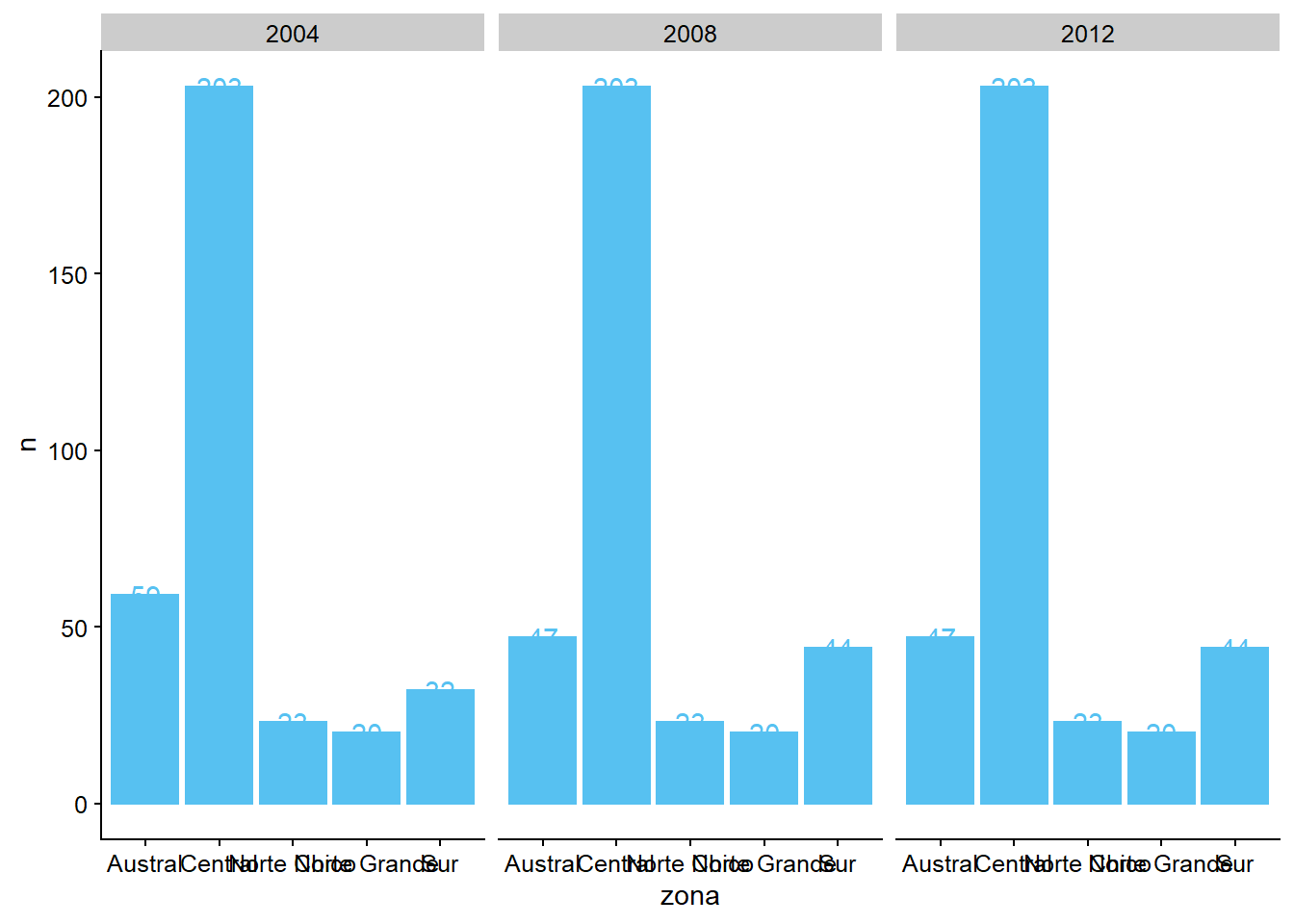

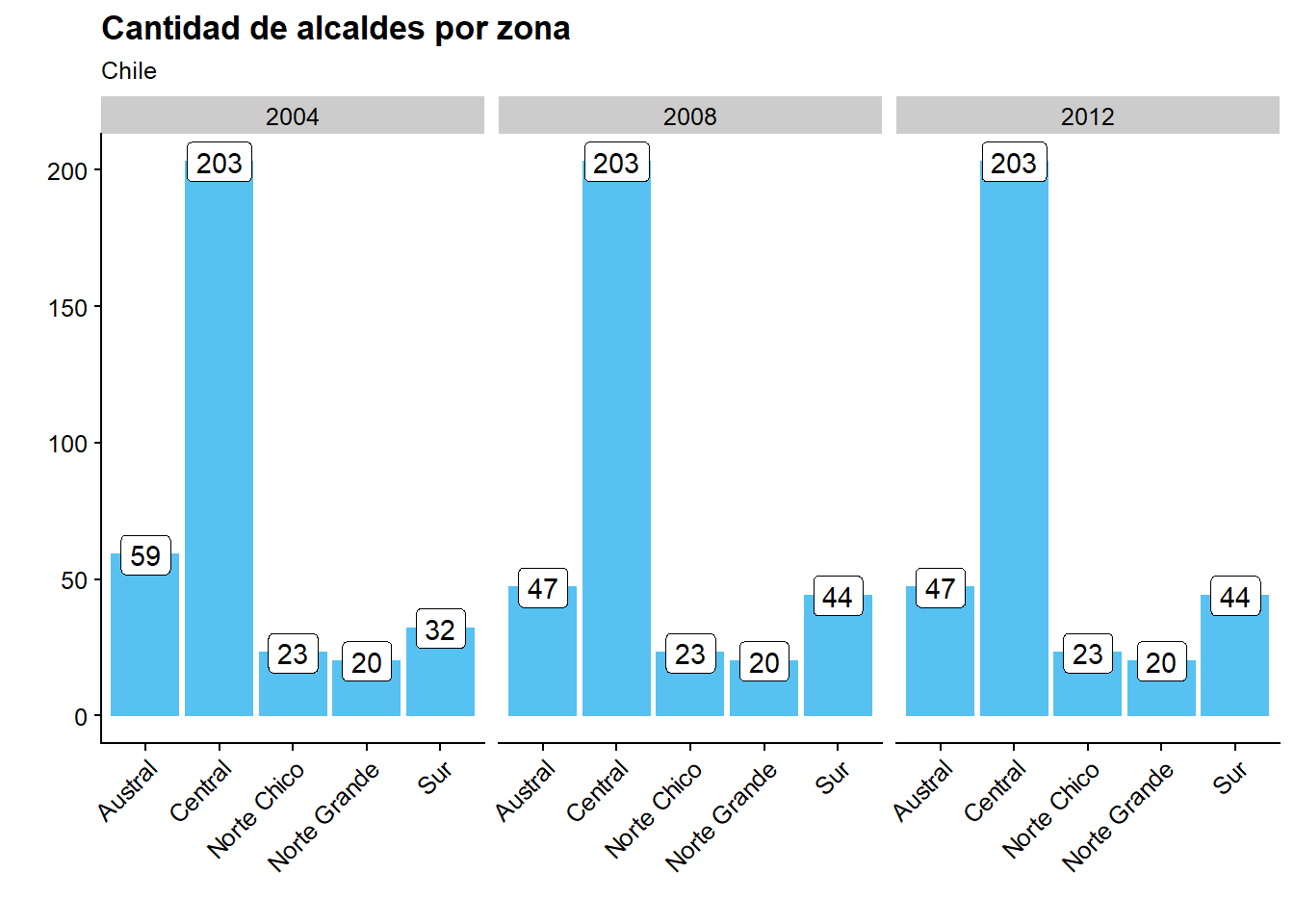

Ejercicio 3D

Normalmente, los gráficos de barras se presentan con la frecuencia o proporción dentro de la barra. También podemos hacer esto con el

ggplot2. Usandogeom_bar()ygeom_text(), apunta el número de alcaldes por área geográfica. Un consejo: tienes que hacer algunos cálculos con tidyverse antes de añadir esa información en la gráfica.

datos_municipales %>%

group_by(anio) %>%

count(zona)

## # A tibble: 15 x 3

## # Groups: anio [3]

## anio zona n

## <chr> <chr> <int>

## 1 2004 Austral 59

## 2 2004 Central 203

## 3 2004 Norte Chico 23

## # ... with 12 more rows

ggplot(datos_municipales %>%

group_by(anio) %>%

count(zona),

aes(x = zona, y = n)) +

geom_bar(stat = "identity") +

facet_grid(~ anio) +

geom_text(aes(label = n))

Mejoramos la presentación:

ggplot(datos_municipales %>%

group_by(anio) %>%

count(zona),

aes(x = zona, y = n)) +

geom_bar(stat = "identity") +

facet_grid(~ anio) +

geom_label(aes(label = n)) +

labs(title = "Cantidad de alcaldes por zona",

subtitle = "Chile",

y = "",

x = "") +

theme(axis.text.x = element_text(angle = 45, hjust = 1)) #Cambiar ángulo de etiquetas en eje x

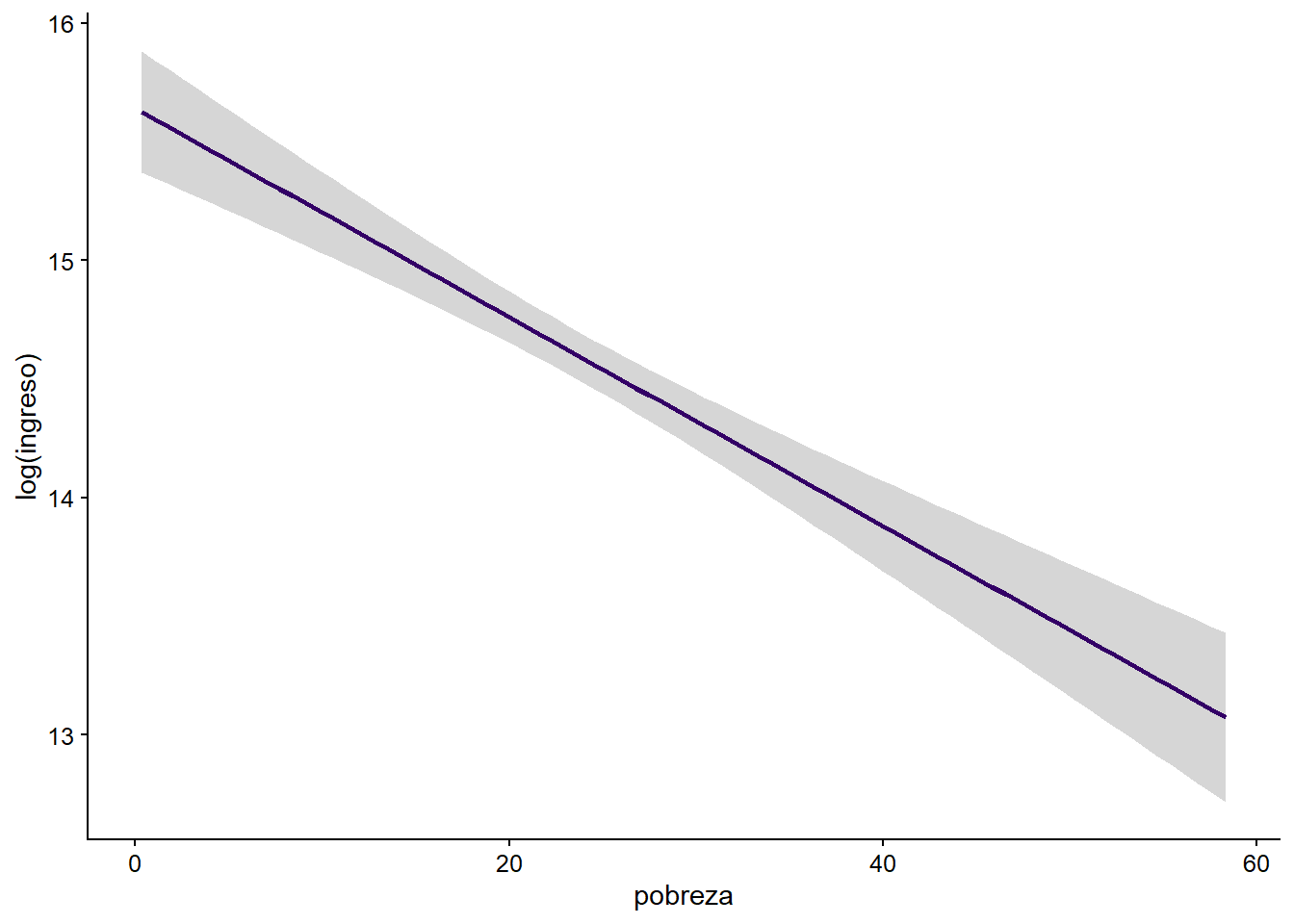

Ejercicio 3E

Escogiendo sólo un año, haz un gráfico de líneas con geom_smooth que indique la relación entre los ingresos y la tasa de pobreza. Ahora, con annotate, haz un gráfico de caja que contenga los municipios con mayor índice de pobreza y, encima de él, escribe el nombre del municipio correspondiente.

grafico1_3e <- ggplot(datos_municipales %>%

filter(anio == 2004),

aes(x = pobreza, y = log(ingreso))) +

geom_smooth(method = "lm", color = "#330066")

grafico1_3e

## Warning: Removed 40 rows containing non-finite values (stat_smooth).

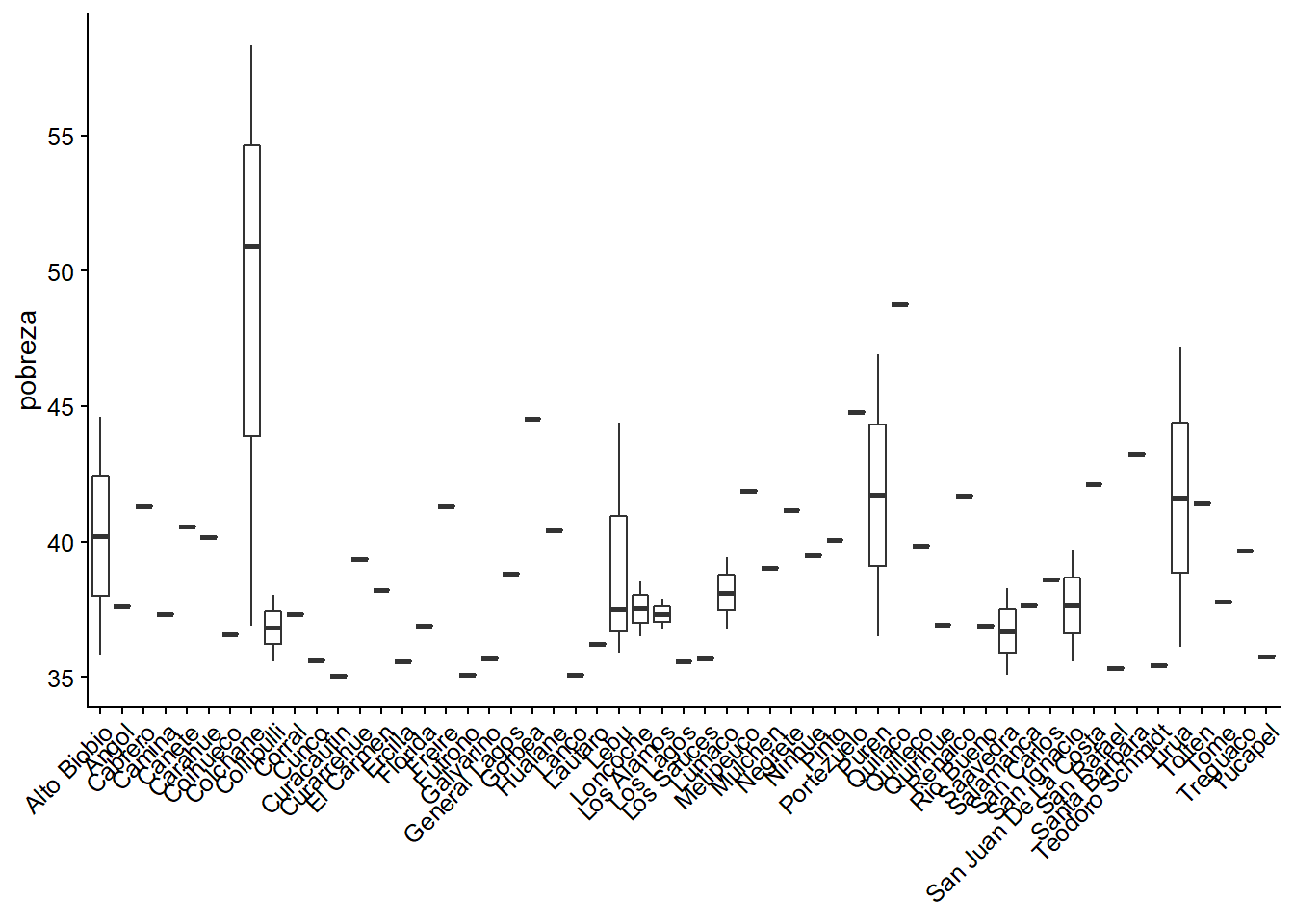

Ahora pasaremos al gráfico de cajas con las municipalidades. Para este ejercicio no vamos a filtrar las observaciones para tener sólo un año, ya que necesitamos la variación en el tiempo para crear las cajas. Vayamos paso a paso!

En primer lugar, creamos el gráfico con las cajas que representan la pobreza de los municipios.

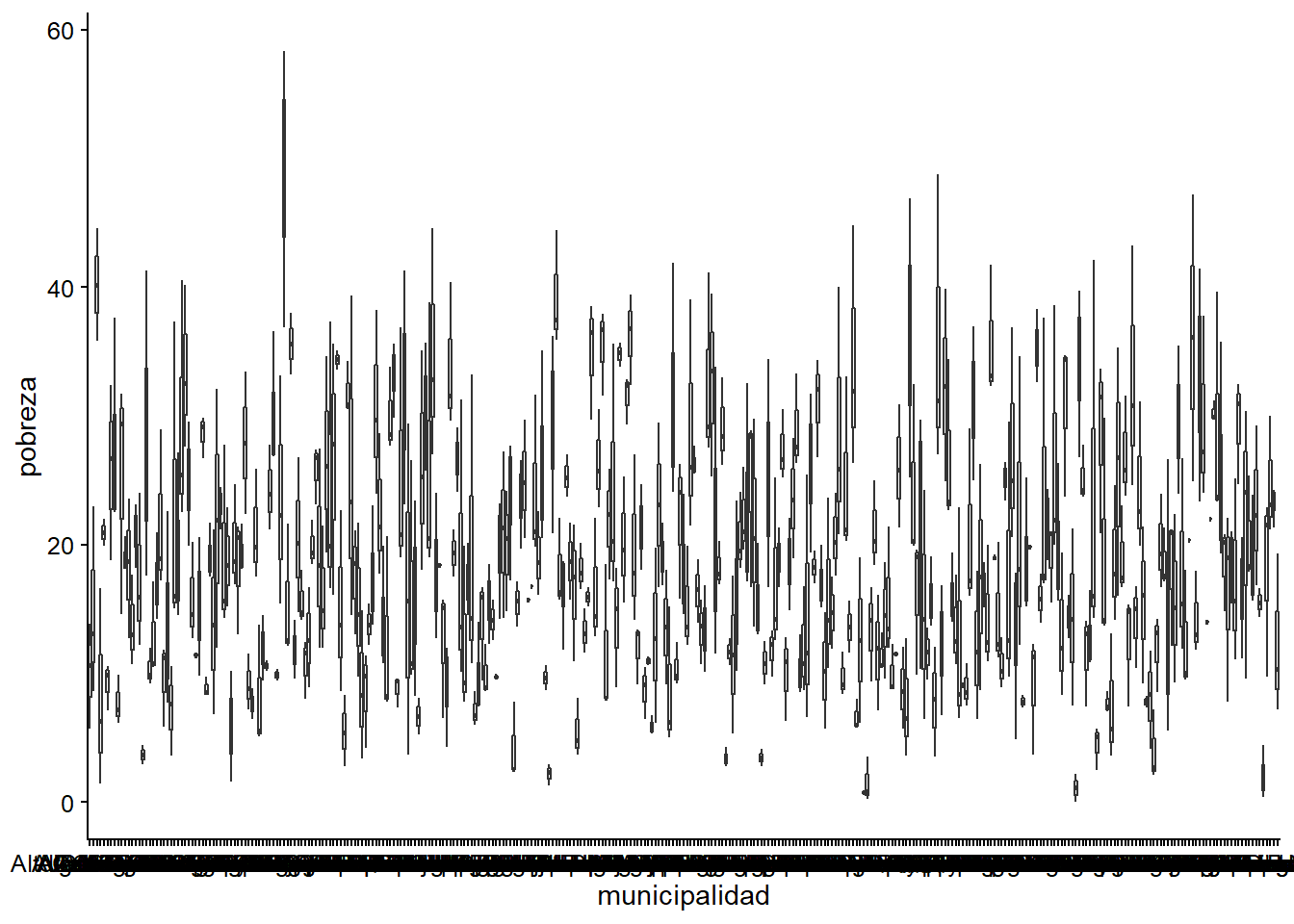

ggplot(datos_municipales,

aes(x = municipalidad, y = pobreza)) +

geom_boxplot()

## Warning: Removed 47 rows containing non-finite values (stat_boxplot).

Vemos que no es muy legible, por lo que pasaremos a filtrar sólo aquellas observaciones en que el porcentaje de personas en situación de pobreza es mayor a 35%.

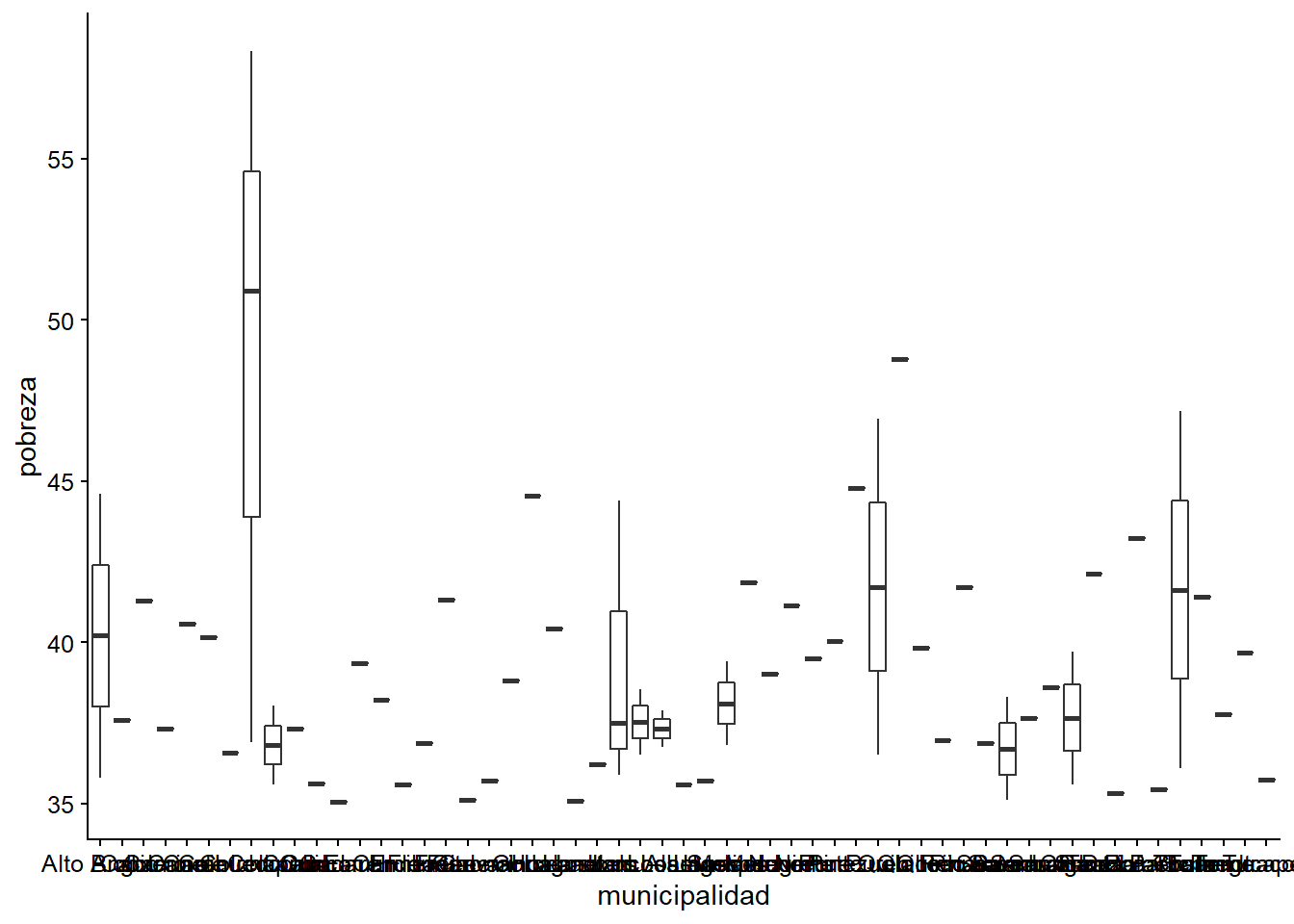

ggplot(datos_municipales %>%

filter(pobreza >= 35),

aes(x = municipalidad, y = pobreza)) +

geom_boxplot()

Ahora va quedando mejor, sin embargo, las etiquetas en el eje x todavía no pueden leerse. A continuación verás dos opciones de lo que se podría hacer para mejorar el gráfico (recuerda que pueden haber otras formas de hacerlo, todo depende de lo que quieras hacer y mostrar!)

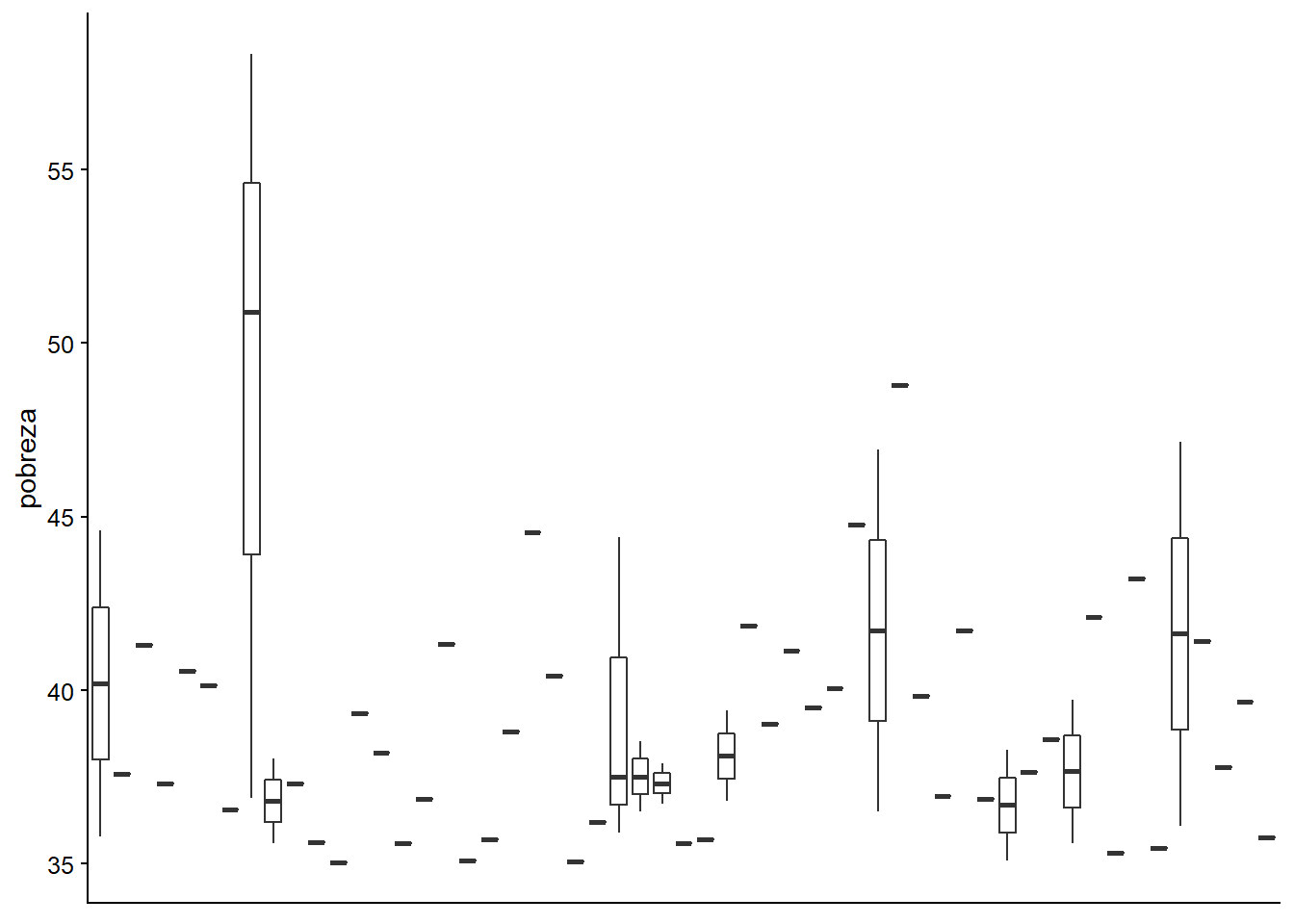

Alternativa 1

A continuación vamos a quitar todas las etiquetas del eje X (tanto el nombre del eje como los valores del mismo)

ggplot(datos_municipales %>%

filter(pobreza >= 35),

aes(x = municipalidad, y = pobreza)) +

geom_boxplot() +

theme(axis.title.x=element_blank(),

axis.text.x=element_blank(),

axis.ticks.x=element_blank())

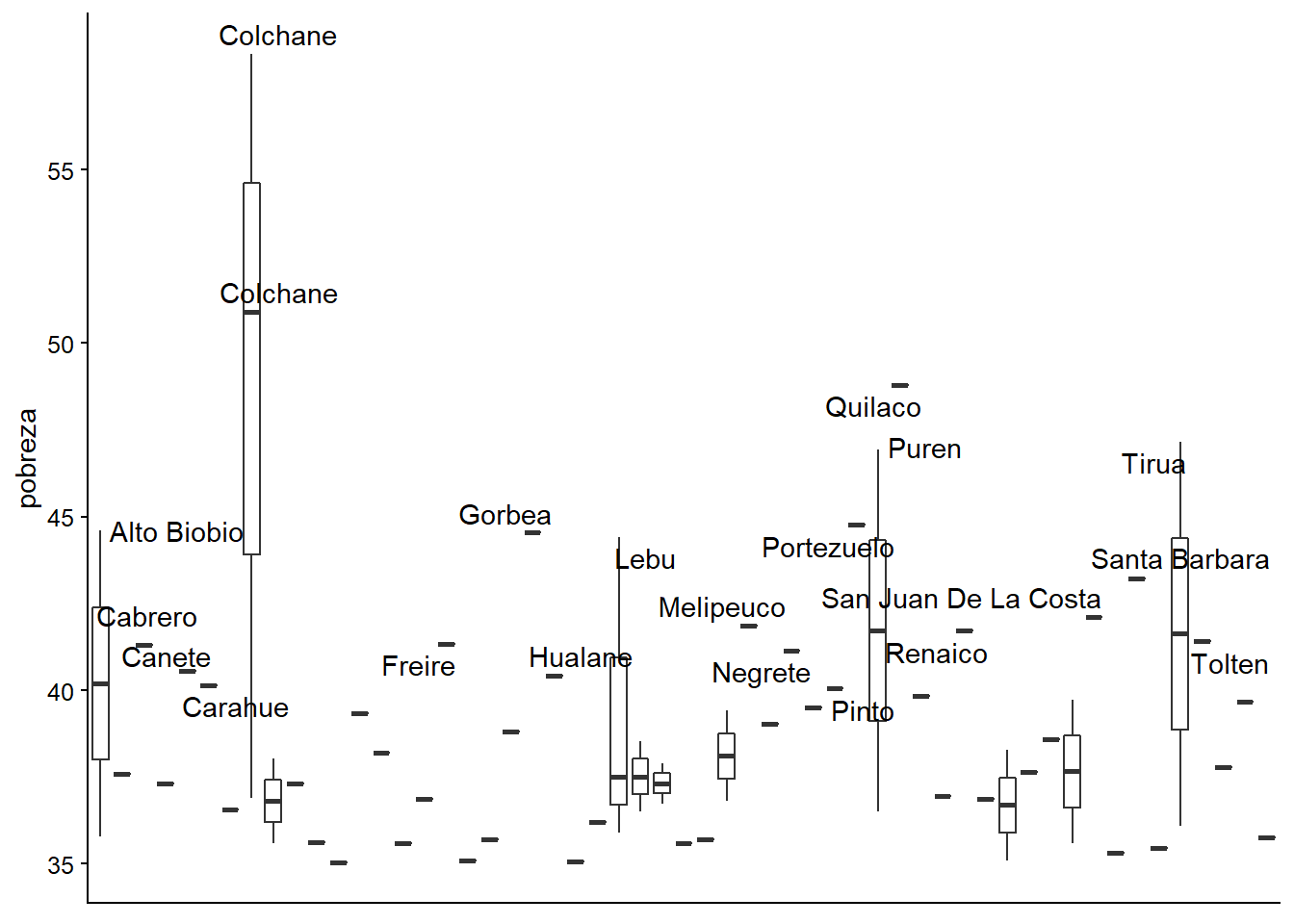

Ahora le agregamos el nombre de la municipalidad a aquellas observaciones en donde la pobreza es mayor o igual al 40%

ggplot(datos_municipales %>%

filter(pobreza >= 35),

aes(x = municipalidad, y = pobreza)) +

geom_boxplot() +

theme(axis.title.x=element_blank(),

axis.text.x=element_blank(),

axis.ticks.x=element_blank()) +

geom_text_repel(data = datos_municipales %>%

filter(pobreza >= 40), aes(x = municipalidad, label = municipalidad))

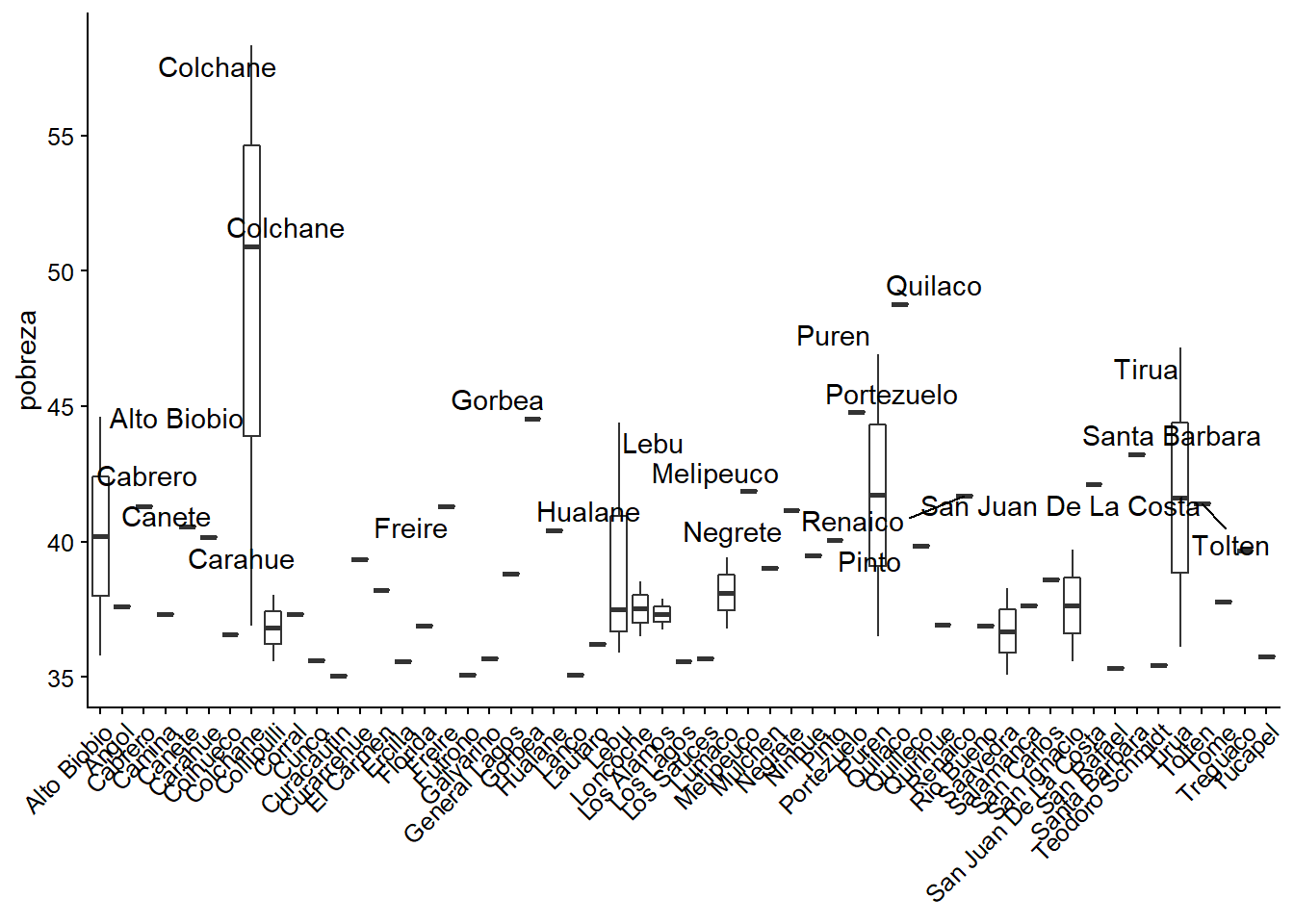

Alternativa 2

Ahora en vez de sacar la información del eje X, vamos a cambiar la orientación de las etiquetas en 45°:

ggplot(datos_municipales %>%

filter(pobreza >= 35),

aes(x = municipalidad, y = pobreza)) +

geom_boxplot() +

theme(axis.text.x = element_text(angle = 45, hjust = 1),

axis.title.x=element_blank())

Si quisieramos, podríamos agregarle neuvamente las etiquetas de aquellas municipalidades en donde la pobreza es igual o mayor al 40%

ggplot(datos_municipales %>%

filter(pobreza >= 35),

aes(x = municipalidad, y = pobreza)) +

geom_boxplot() +

theme(axis.text.x = element_text(angle = 45, hjust = 1),

axis.title.x=element_blank()) +

geom_text_repel(data = datos_municipales %>%

filter(pobreza >= 40), aes(x = municipalidad, label = municipalidad))

Capítulo 4: Carga de bases

Paquetes y carga de datos

library(tidyverse)

library(paqueteadp)

library(haven)

## install.packages("readxl")

library(readxl)

library(janitor)Ejercicio 4A

Desde la página web de Latinobarómetro, descarga la edición 2017 en formato SPSS (.sav) e impórtelas a R. Ten cuidado con las etiquetas

Este ejercicio puede tener distintos nombres, dependiendo del nombre de las carpetas, ordenador, etc.

getwd() #Este comando nos sirve para saber la direccion de la carpeta en la que trabajamos

## [1] "C:/Users/andres/Dropbox/Proyecto de libro/libroadp_es_v1"

df_latinobarometro2017_spss <- read_spss("00-archivos/ejercicios/capitulo 4/latinobarometro2017_sav/Latinobarometro2017Eng_v20180117.sav")

glimpse(df_latinobarometro2017_spss) # Notamos que hay etiquetas en las variables

## Rows: 20,200

## Columns: 324

## $ NUMINVES <dbl+lbl> 2017, 2017, 2017, 2017, 2017, 2017, 2017, 2017, ~

## $ IDENPA <dbl+lbl> 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, ~

## $ NUMENTRE <dbl> 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 1~

## $ REG <dbl+lbl> 32301, 32301, 32301, 32301, 32301, 32301, 32301,~

## $ CIUDAD <dbl+lbl> 3.2e+07, 3.2e+07, 3.2e+07, 3.2e+07, 3.2e+07, 3.2~

## $ TAMCIUD <dbl+lbl> 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, ~

## $ COMDIST <dbl> 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 3, 3~

## $ CODIGO <dbl> 37, 43, 37, 43, 37, 43, 43, 37, 43, 37, 37, 43, 37, ~

## $ DIAREAL <dbl+lbl> 29, 29, 29, 29, 29, 29, 29, 29, 4, 4, 4, 4, ~

## $ MESREAL <dbl+lbl> 7, 7, 7, 7, 7, 7, 7, 7, 8, 8, 8, 8, 8, 8, 8, 8, ~

## $ INI <dbl> 1053, 1103, 1149, 1158, 1251, 1432, 1306, 1354, 1141~

## $ FIN <dbl> 1128, 1146, 1227, 1241, 1346, 1505, 1351, 1422, 1212~

## $ DURA <dbl> 35, 43, 38, 43, 55, 33, 45, 28, 31, 33, 27, 30, 37, ~

## $ TOTREVI <dbl> 0, 0, 1, 0, 0, 0, 2, 0, 0, 0, 0, 0, 1, 0, 0, 4, 0, 0~

## $ TOTCUOT <dbl+lbl> 0, 1, 5, 0, 1, 1, 4, 0, 0, 0, 0, 0, 0, 1, 1, 0, ~

## $ TOTRECH <dbl+lbl> 3, 1, 3, 1, 3, 0, 1, 0, 1, 0, 0, 0, 2, 1, 2, 3, ~

## $ TOTPERD <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ NUMCASA <dbl+lbl> 4, 2, 4, 2, 4, 1, 2, 1, 2, 1, 1, 1, 3, 2, 3, 4, ~

## $ CODSUPER <dbl+lbl> 1, 1, 1, 1, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ SUPERVVI <dbl+lbl> 1, 2, 1, 1, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ SUPERVEN <dbl+lbl> 0, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ CODIF <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ DIGIT <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ WT <dbl+lbl> 1.58, 0.71, 1.00, 0.71, 0.71, 0.71, 0.71, 0.71, ~

## $ P1ST <dbl+lbl> 3, 3, 1, 2, 2, 3, 1, 1, 1, 1, 1, 1, 1, 1, 1, 3, ~

## $ P2ST <dbl+lbl> 2, 2, NA, 1, 1, 3, 1, 2, 1, 2, 2, 3, ~

## $ P3STGBS <dbl+lbl> 7, 25, 6, 13, 6, 6, 13, 6, 15, 25, 25, 7, ~

## $ P4STGBSC <dbl+lbl> 4, 3, 3, 4, 2, 4, 3, 3, 2, 4, 3, 4, 3, 5, 3, 4, ~

## $ P5STGBS <dbl+lbl> 4, 4, 2, 4, 3, 5, 4, 4, 3, 4, 4, 4, 4, 4, 2, 5, ~

## $ P6STICC1 <dbl+lbl> 2, 2, 2, 2, 3, 4, 1, 4, 4, 4, NA, NA, ~

## $ P7STGBS <dbl+lbl> 3, 3, 1, 2, 3, 2, 2, 3, 2, 2, 2, 3, ~

## $ P8STGBS <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 1, 3, 2, 3, 1, ~

## $ P9STGBSC.A <dbl+lbl> 3, 3, 1, 3, 2, 2, 3, 1, 4, 1, 3, 2, ~

## $ P9STGBS.B <dbl+lbl> 3, 4, 3, 3, 2, 4, 3, 4, 2, 3, 3, 3, 4, 4, 4, 3, ~

## $ P10ST <dbl+lbl> 1, 1, 2, NA, 1, 1, 2, 1, 2, 2, 1, 1, ~

## $ P11STGBSC <dbl+lbl> 1, 6, 8, 6, 7, 6, 10, 5, 8, 7, 5, 10, ~

## $ P12STC <dbl+lbl> 16, 16, 1, 1, 1, 2, 1, 3, 97, 1, 3, 97, ~

## $ P13STGBS <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P14STGBS.A <dbl+lbl> 2, 4, 2, 1, 1, 3, 1, 3, 1, 3, 2, 2, 3, 3, 3, 3, ~

## $ P14STGBS.B <dbl+lbl> 2, 4, 2, 3, 3, 4, 2, 2, 4, 4, 3, 2, 4, 3, 3, 2, ~

## $ P14ST.C <dbl+lbl> NA, 3, 2, 1, 1, 1, 1, 1, 2, 2, 4, 2, ~

## $ P14ST.D <dbl+lbl> 2, 4, 3, 3, 3, 3, 3, 4, 4, 2, 1, 2, ~

## $ P14ST.E <dbl+lbl> 2, 4, 2, 1, 1, 4, 1, 2, 2, 4, 3, 3, 4, 4, 4, 4, ~

## $ P14ST.F <dbl+lbl> 2, 4, 2, 4, 1, 3, 2, 1, 4, 4, 2, 2, ~

## $ P14ST.G <dbl+lbl> 3, 3, 3, 4, 4, 4, 3, 4, 3, 4, 2, 2, 4, 4, 3, 3, ~

## $ P14ST.H <dbl+lbl> 2, 3, 2, 2, 3, 3, 1, 4, 4, 4, 3, 2, ~

## $ P15ST.A <dbl+lbl> 0, 0, 1, 1, 0, 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 1, ~

## $ P15ST.B <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P15ST.C <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST.D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, ~

## $ P15ST.E <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, ~

## $ P15ST.F <dbl+lbl> 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P15ST.G <dbl+lbl> 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, 0, 0, ~

## $ P15ST.H <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST.I <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 1, 1, 1, ~

## $ P15ST.J <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST.K <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, ~

## $ P16STGBS <dbl+lbl> NA, 95, 32044, 32006, 32044, 32001, NA,~

## $ P16STGBS.A <dbl+lbl> NA, NA, 1, 1, 1, 2, NA, 2, 1, 2, NA, 2, ~

## $ PERPART <dbl+lbl> 4, 4, 1, 1, 1, 2, 4, 2, 1, 2, 4, 2, 4, 4, 2, 2, ~

## $ FAMPART <dbl+lbl> 0, 0, 30, 60, 30, 30, 0, 30, 30, 30, 0, 30, ~

## $ P17STGBSC <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, ~

## $ P18GBS <dbl+lbl> 3, 3, 2, 3, 2, 5, 2, 1, 4, 2, 3, 2, 2, 3, 3, 3, ~

## $ P19STC <dbl+lbl> 0, 5, 8, NA, 8, 4, 5, 5, 5, 8, 5, 6, ~

## $ P20ST <dbl+lbl> 3, 3, NA, 3, 3, 3, 3, 3, 2, 3, 1, 3, ~

## $ P21ST.A <dbl+lbl> 1, 2, 2, 2, NA, 1, 2, 3, 4, 2, 2, 2, ~

## $ P21ST.B <dbl+lbl> 2, 2, 3, 3, 4, 2, 3, 2, NA, 2, 1, 2, ~

## $ P21ST.C <dbl+lbl> 1, 3, 1, 1, 2, 2, 2, 1, NA, 2, 2, 1, ~

## $ P21ST.D <dbl+lbl> 2, 2, 1, 1, 3, 2, 3, 1, 1, 2, 3, 2, 2, 3, 2, 2, ~

## $ P21ST.E <dbl+lbl> 2, 3, 3, 1, 3, 3, 3, 3, 4, 2, 2, 3, 2, 3, 2, 2, ~

## $ P21ST.F <dbl+lbl> 2, 2, 2, 2, NA, 3, 2, 2, 2, 2, 2, 3, ~

## $ P21ST.G <dbl+lbl> 2, 2, 1, 2, 4, 2, 3, 4, 2, 2, 2, 2, ~

## $ P21ST.H <dbl+lbl> 2, 3, 1, 1, 4, 2, 3, 2, 1, 2, 1, 1, 1, 2, 2, 2, ~

## $ P22ST <dbl+lbl> 4, 3, 1, 1, 1, 2, 1, 2, 3, 2, 3, 2, 2, 4, 2, 2, ~

## $ P23STC <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 2, 1, 1, 2, 1, 1, 2, 1, 4, ~

## $ P24STC <dbl+lbl> 2, 2, 1, 1, 1, 1, 3, NA, 1, 2, 2, 1, ~

## $ P25STTI <dbl+lbl> 2, 1, 1, 1, 1, 1, 2, 1, 1, 2, 4, 1, 2, 3, 1, 1, ~

## $ P26ST <dbl+lbl> 2, 2, 4, 4, 2, 2, 4, 4, 1, 2, 2, 2, 4, 3, 2, 1, ~

## $ P27ST <dbl+lbl> 2, 2, 1, 3, 1, 2, 1, 2, 2, 2, 2, 2, ~

## $ P28N.A <dbl+lbl> 8, 8, 8, 8, 8, 2, 1, 2, 2, 8, 2, 8, 8, 2, 8, 8, ~

## $ P28N.B <dbl+lbl> 8, 8, 2, 2, 8, 2, 1, 2, 2, 8, 2, 8, ~

## $ P28N.C <dbl+lbl> 2, 8, 8, 8, 8, 2, 2, 8, 8, 8, 2, 8, 8, 1, 8, 8, ~

## $ P28N.D <dbl+lbl> 8, 8, 8, 8, 8, 2, 8, 2, 2, 8, 2, 8, ~

## $ P28N.E <dbl+lbl> 8, 1, 2, 2, 2, 2, 2, 2, 2, 8, 2, 8, ~

## $ P28N.F <dbl+lbl> 8, 8, 2, 2, 2, 2, 2, 2, 2, 8, 2, 8, ~

## $ P29NSPA <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 1, 1, 1, 0, 1, 1, 0, ~

## $ P29NSPB <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P29NSPC <dbl+lbl> 0, 1, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, ~

## $ P29NSPD <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPE <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPF <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPG <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPH <dbl+lbl> 1, 1, 1, 1, 1, 1, 0, 1, 1, 0, 0, 0, 1, 1, 0, 0, ~

## $ P29NSPI <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 1, 0, ~

## $ P29NSPJ <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, ~

## $ P29NSPZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPX <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P30NSP <dbl+lbl> 10, 10, 8, 1, 9, 10, 5, 1, 1, 10, 10, 1, ~

## $ P31NSP <dbl+lbl> NA, NA, 1, 1, 3, NA, 1, 1, 1, NA, NA, 1, ~

## $ P32NSP.A <dbl+lbl> NA, NA, 2, 1, 1, NA, 1, 1, 1, NA, NA, 6, ~

## $ P33NSP <dbl+lbl> NA, NA, 1, 1, 1, NA, 1, 1, 1, NA, NA, 2, ~

## $ P34NA <dbl+lbl> NA, NA, NA, 1, 9, NA, NA, 24, NA, NA, NA, 1, ~

## $ P34NB <dbl+lbl> 99, 99, 10, 0, 0, 99, 15, 0, 20, 99, 99, 0, ~

## $ P35NC <dbl+lbl> 1, 1, 3, 2, 0, 1, 1, 1, 0, 2, 0, 3, ~

## $ P36C <dbl+lbl> 2, 1, 2, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P37NC <dbl+lbl> NA, 2, 1, 2, 1, 1, 1, 1, 1, 2, 1, 1, ~

## $ P38ST <dbl+lbl> 4, 2, 1, 4, 1, 4, 2, 3, 2, 3, 1, 2, ~

## $ P39STTI <dbl+lbl> 3, 3, 4, 3, 4, 2, 3, 3, 4, 2, 2, 2, ~

## $ P40NC_A <dbl+lbl> 1, NA, 2, NA, 0, NA, 2, NA, 2, NA, 1, NA, ~

## $ P40NC_B <dbl+lbl> NA, 2, NA, 1, NA, 2, NA, 1, NA, 1, NA, 2, ~

## $ P41STC.A <dbl+lbl> 1, 5, 4, NA, 5, 5, 5, 4, 5, 4, 1, 4, ~

## $ P41STC.B <dbl+lbl> 2, 5, 4, NA, 5, 5, 3, 2, 5, 4, 1, 3, ~

## $ P41STC.C <dbl+lbl> 2, NA, 2, NA, 5, 5, 2, 2, 5, 4, 1, 3, ~

## $ P42NC.A <dbl+lbl> 5, 5, 7, 10, 7, 3, 7, 5, 10, 7, 6, 7, ~

## $ P42NC.B <dbl+lbl> 5, 6, 7, 4, 8, 1, 9, 5, 5, 6, 6, 8, ~

## $ P42NC.C <dbl+lbl> 2, 6, 8, 6, NA, 1, 9, 8, 2, 8, 0, 9, ~

## $ P42NC.D <dbl+lbl> 6, 6, 3, 10, 7, 10, 8, 5, 10, 8, 0, 8, ~

## $ P42NC.E <dbl+lbl> 6, 4, 5, 10, 8, 5, 4, 5, 10, 8, 0, 7, ~

## $ P42NC.F <dbl+lbl> 6, 4, 5, 10, 10, NA, 1, 7, 10, 7, 0, 7, ~

## $ P43ST.A <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 1, 4, 1, 1, 2, ~

## $ P43ST.B <dbl+lbl> 2, 1, 2, 1, 1, 2, 1, 1, 4, 1, 1, 2, ~

## $ P44N <dbl+lbl> 5, 3, 5, NA, 5, 5, 4, 2, 6, 3, 3, 5, ~

## $ P45ST.A <dbl+lbl> 2, 2, 2, 4, 2, 4, 3, 2, 2, 2, 2, 2, ~

## $ P45N.B <dbl+lbl> NA, 3, NA, NA, NA, NA, 3, NA, NA, NA, 2, NA, ~

## $ P45ST.C <dbl+lbl> 2, 2, 2, 2, 2, NA, 2, NA, 2, NA, 2, 2, ~

## $ P45ST.D <dbl+lbl> NA, NA, 1, 2, 2, NA, 1, NA, 3, NA, 2, NA, ~

## $ P45ST.E <dbl+lbl> NA, 2, 3, NA, NA, NA, 2, NA, 3, NA, 2, NA, ~

## $ P45N.F <dbl+lbl> 4, 3, NA, NA, NA, NA, 2, NA, 3, NA, 2, NA, ~

## $ P46ST.A <dbl+lbl> NA, 2, 2, 2, 1, 3, 2, NA, 2, 2, NA, 2, ~

## $ P46ST.B <dbl+lbl> NA, 3, NA, NA, 3, NA, 2, NA, NA, NA, NA, NA, ~

## $ P46ST.C <dbl+lbl> 2, 3, 2, NA, 2, NA, 1, NA, 2, NA, NA, NA, ~

## $ P46ST.D <dbl+lbl> 2, 3, 2, 2, 3, NA, 2, NA, 3, NA, NA, NA, ~

## $ P46STM.E <dbl+lbl> NA, 4, NA, NA, 3, NA, 3, NA, 3, NA, NA, NA, ~

## $ P47N <dbl+lbl> 2, 3, 1, 3, 2, 4, 1, 1, 1, 3, 3, 3, ~

## $ P48STM <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, NA, 2, 2, NA, 1, ~

## $ P49STA.1 <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 1, 2, 1, 1, 1, 2, 1, 2, ~

## $ P49STA.2 <dbl+lbl> 2, 2, 1, 2, 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA.3 <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA.4 <dbl+lbl> 1, 1, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA.5 <dbl+lbl> 2, 2, 2, 2, 2, 1, 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, ~

## $ P49STA.6 <dbl+lbl> 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA.7 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 2, 1, 2, 1, 1, 2, 2, 1, 2, ~

## $ P49STA.8 <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, ~

## $ P49STB.1 <dbl+lbl> NA, 2, 2, 3, 3, NA, 1, NA, 2, NA, 2, 1, ~

## $ P49STB.2 <dbl+lbl> NA, NA, 2, NA, 1, NA, 3, NA, 2, NA, NA, NA, ~

## $ P49STB.3 <dbl+lbl> NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, ~

## $ P49STB.4 <dbl+lbl> 2, 2, NA, 3, 1, NA, 2, NA, NA, NA, NA, NA, ~

## $ P49STB.5 <dbl+lbl> NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, 2, NA, ~

## $ P49STB.6 <dbl+lbl> NA, NA, NA, NA, 1, NA, NA, NA, NA, NA, NA, NA, ~

## $ P49STB.7 <dbl+lbl> 2, 4, 2, 4, 3, NA, 3, NA, 4, NA, 1, 2, ~

## $ P49STB.8 <dbl+lbl> NA, 4, 2, 4, 3, NA, 3, NA, NA, NA, 1, NA, ~

## $ P50STM <dbl+lbl> NA, 4, 1, 1, 2, 97, 4, NA, 7, NA, NA, NA, ~

## $ P51STMA <dbl+lbl> 0, 1, 0, 1, 1, 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, ~

## $ P51STMB <dbl+lbl> 1, 1, 1, 0, 1, 1, 1, 0, 1, 0, 1, 1, 1, 1, 0, 1, ~

## $ P51STMC <dbl+lbl> 0, 0, 1, 1, 1, 0, 1, 1, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMD <dbl+lbl> 0, 0, 1, 1, 1, 0, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STME <dbl+lbl> 0, 0, 0, 1, 1, 0, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, ~

## $ P51STMF <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, ~

## $ P51STMG <dbl+lbl> 0, 0, 0, 1, 1, 1, 1, 0, 1, 0, 0, 1, 1, 1, 0, 0, ~

## $ P51STMH <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMI <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMJ <dbl+lbl> 0, 0, 1, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMK <dbl+lbl> 0, 1, 0, 1, 0, 1, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NA <dbl+lbl> 1, 0, 1, 1, 0, 0, 1, 1, 0, 1, 1, 1, 1, 0, 1, 1, ~

## $ P52NB <dbl+lbl> 0, 1, 0, 0, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NC <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52ND <dbl+lbl> 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NE <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52NF <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52NZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, ~

## $ P53ST.A <dbl+lbl> 2, 2, 2, 2, 1, 2, 1, 1, 2, 1, 1, 3, ~

## $ P53N.B <dbl+lbl> 2, 3, 1, 2, 2, 2, 3, 4, 1, 2, 2, 2, ~

## $ P53N.C <dbl+lbl> 2, 3, 3, NA, 4, 2, 3, 4, 3, 4, NA, 3, ~

## $ P53N.D <dbl+lbl> 1, 3, 3, 1, 2, 2, 4, 4, 3, 1, 4, 4, ~

## $ P53N.E <dbl+lbl> 2, 2, 2, 2, 1, 1, 1, 1, 2, 1, 2, 2, ~

## $ P53N.F <dbl+lbl> 2, 2, 1, 1, 2, 2, 3, 4, 2, 1, 2, 3, ~

## $ P53N.G <dbl+lbl> 2, 2, 1, 1, 2, 2, 3, 4, 2, 1, 2, 3, ~

## $ P53N.H <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 4, 1, 1, 2, 1, ~

## $ P53N.I <dbl+lbl> 1, 1, 1, 1, 1, 3, 1, 1, 1, 1, 4, 1, ~

## $ P54STMA <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ P54STMB <dbl+lbl> 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P54STMC <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, ~

## $ P54STMD <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STME <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMF <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMG <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ P54STMH <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMI <dbl+lbl> 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMJ <dbl+lbl> 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMX <dbl+lbl> 1, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMZ <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P55N.A <dbl+lbl> 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ P55N.B <dbl+lbl> 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P55N.C <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P56N.A <dbl+lbl> 1, 2, 1, 1, 1, 3, 3, 4, 1, 1, 2, 2, 1, 1, 1, 1, ~

## $ P56N.B <dbl+lbl> 1, 2, 3, 1, 1, 1, 3, 4, 1, 1, 1, 3, 1, 1, 1, 1, ~

## $ P56N.C <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, ~

## $ P56N.D <dbl+lbl> 1, 2, 1, 2, 1, 2, 3, 1, 1, 1, 1, 1, ~

## $ P56N.E <dbl+lbl> 1, 2, 1, 1, 1, 1, 1, 4, 1, 1, 1, 2, 1, 1, 1, 4, ~

## $ P56N.F <dbl+lbl> 2, 2, 1, 2, 2, 2, 1, 1, 2, 1, 1, 2, ~

## $ P56N.G <dbl+lbl> 1, 3, 1, 2, 1, 2, NA, 1, 2, 2, 1, 3, ~

## $ P57N <dbl+lbl> 2, 1, 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 1, 2, ~

## $ P58N <dbl+lbl> 2, 2, 1, 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P59N <dbl+lbl> NA, 1, 1, 1, 1, 2, 2, 1, 1, 1, 1, 1, ~

## $ P60N <dbl+lbl> 1, 1, 1, 1, 1, 2, 1, 2, 1, 2, 2, 1, ~

## $ P61ST.1 <dbl+lbl> NA, 5, 5, 4, NA, 1, 2, NA, 1, 8, -6, 8, ~

## $ P61ST.2 <dbl+lbl> 0, 4, 0, 0, 4, 0, 4, 8, 0, NA, NA, 2, ~

## $ P61ST.3 <dbl+lbl> 10, 7, 9, 9, 8, 10, 10, 10, 2, 8, NA, 10, ~

## $ P62NA <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 0, 0, 1, 1, 0, 1, 0, 0, 0, ~

## $ P62NB <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, ~

## $ P62NC <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 1, 1, 1, 0, 1, 1, 1, 1, 1, ~

## $ P62ND <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, ~

## $ P62NE <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 0, 1, 1, 0, 1, 0, 0, 0, 0, ~

## $ P62NF <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, ~

## $ P62NG <dbl+lbl> 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 0, 1, 1, 0, 0, 0, ~

## $ P62NH <dbl+lbl> 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, ~

## $ P62NI <dbl+lbl> 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NJ <dbl+lbl> 1, 1, 1, 0, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P62NK <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P62NX <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NY <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63A <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63B <dbl+lbl> 0, 1, 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63C <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P63D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63E <dbl+lbl> 0, 0, 1, 0, 1, 1, 1, 1, 0, 0, 0, 0, 0, 1, 1, 0, ~

## $ P63F <dbl+lbl> 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63G <dbl+lbl> 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63H <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63I <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, ~

## $ P63J <dbl+lbl> 0, 0, 1, 0, 1, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63K <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, 0, ~

## $ P63X <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63Y <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, ~

## $ P63Z <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STAA <dbl+lbl> 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P64STAB <dbl+lbl> 0, 0, 1, 1, 1, 1, 1, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P64STAC <dbl+lbl> 0, 0, 0, 1, 1, 1, 1, 0, 0, 0, 0, 1, 1, 1, 0, 1, ~

## $ P64STAD <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 1, 1, 0, 0, 1, 1, 1, 0, 1, ~

## $ P64STAE <dbl+lbl> 1, 0, 0, 1, 1, 1, 1, 1, 1, 0, 0, 1, 1, 0, 0, 0, ~

## $ P64STAF <dbl+lbl> 0, 0, 1, 1, 0, 1, 0, 1, 0, 0, 0, 1, 1, 1, 1, 1, ~

## $ P64STAG <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, ~

## $ P64STAH <dbl+lbl> 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, ~

## $ P64STAZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBA <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBB <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBC <dbl+lbl> 1, 0, 0, 1, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, ~

## $ P64STBD <dbl+lbl> 1, 1, 1, 1, 1, 0, 1, 1, 1, 0, 1, 0, 0, 0, 1, 0, ~

## $ P64STBE <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBF <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P64STBG <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBH <dbl+lbl> 1, 1, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBZ <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P65ST.A <dbl+lbl> 4, 4, 1, 4, 4, 4, 1, 1, 2, 1, 4, 4, 4, 2, 4, 4, ~

## $ P65ST.B <dbl+lbl> 4, 4, 4, 4, 4, 4, 1, 4, 2, 4, 4, 4, 4, 2, 4, 4, ~

## $ P66ST <dbl+lbl> 1, 1, 1, 1, 1, 1, 2, 1, 1, 1, 4, 1, 1, 1, 1, 1, ~

## $ P67NBCS <dbl+lbl> 3, 3, 2, NA, 2, 2, 2, 4, NA, 1, 3, NA, ~

## $ P68NBCS <dbl+lbl> 1, 1, 2, 2, 1, 2, 2, 1, 2, 2, 2, 2, 1, 2, 1, 2, ~

## $ P69NBCS <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 2, 1, 1, 3, 1, 4, 1, 2, ~

## $ P70N_A <dbl+lbl> 0, NA, 1, NA, 0, NA, 2, NA, 1, NA, 0, NA, ~

## $ P70N_B <dbl+lbl> NA, 0, NA, 2, NA, 1, NA, 1, NA, 0, NA, 3, ~

## $ P71N <dbl+lbl> 2, 2, 1, 1, 1, 2, 1, 2, 2, 2, 1, 1, ~

## $ P72NR <dbl+lbl> 1, 4, 2, 4, 1, 4, 2, 1, 5, 4, 4, 3, 4, 4, 4, 4, ~

## $ P73NR <dbl+lbl> 1, 4, 2, 4, 1, 4, 1, 1, 5, 4, 4, 2, ~

## $ P74NR <dbl+lbl> 1, 1, NA, 1, NA, 4, 1, 4, 5, 5, 4, 5, ~

## $ P75NR <dbl+lbl> 4, 4, 4, 4, 4, 4, 5, 5, 3, 4, 4, 5, ~

## $ P76NR <dbl+lbl> 3, 1, 3, 2, 3, 4, 1, 1, 3, 4, 4, 4, 4, 4, 4, 5, ~

## $ SEXO <dbl+lbl> 2, 1, 2, 2, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ S1 <dbl+lbl> 3, 4, 3, 4, 4, 5, 4, 3, 3, 3, 3, 4, 3, 3, 3, 3, ~

## $ EDAD <dbl> 61, 39, 38, 48, 67, 45, 48, 22, 42, 33, 22, 22, 26, ~

## $ S2 <dbl+lbl> 2, 2, 2, 1, 2, 1, 2, 1, 2, 1, 1, 1, 2, 1, 2, 2, ~

## $ S3 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S4 <dbl+lbl> 5, 2, 4, 4, 5, 2, 4, 5, 4, 2, 2, 1, 5, 5, 1, 5, ~

## $ S5 <dbl+lbl> 2, 2, 2, 3, 2, 4, 2, 2, 1, 2, 2, 3, 2, 4, 2, 2, ~

## $ S6 <dbl+lbl> 1, 1, 1, 3, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, ~

## $ S7 <dbl+lbl> 2e+07, 2e+07, 2e+07, 2e+07, 2e+07, 2e+07, 2e+07,~

## $ S8 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S9 <dbl+lbl> 12, 1, 97, 2, 1, 1, 1, 97, 1, 97, 97, 1, ~

## $ S9.A <dbl+lbl> NA, 4, NA, 2, 2, 2, 3, NA, 4, NA, NA, 2, ~

## $ S10 <dbl+lbl> 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, ~

## $ S11 <dbl+lbl> NA, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ S12 <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ S13 <dbl+lbl> 13, 30, 21, 16, 17, 35, 15, 19, 14, 21, NA, 22, ~

## $ S14 <dbl+lbl> 8, 13, 17, 9, 10, 13, 11, 12, 10, 13, 12, 17, ~

## $ REEDUC.1 <dbl+lbl> 3, 5, 7, 4, 4, 5, 4, 4, 4, 5, 4, 7, 5, 3, 5, 2, ~

## $ S15 <dbl+lbl> 1, 8, 10, NA, 3, 4, 13, 13, NA, 8, 1, 13, ~

## $ REEDUC.2 <dbl+lbl> 1, 3, 4, NA, 2, 2, 5, 5, NA, 3, 1, 5, ~

## $ REEDAD <dbl+lbl> 4, 2, 2, 3, 4, 3, 3, 1, 3, 2, 1, 1, 2, 1, 2, 1, ~

## $ S16M_A <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 1, 0, 1, 1, 1, 1, 0, 1, 1, ~

## $ S16M_B <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ S16M_C <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 0, 0, 0, 0, 1, 1, 1, 1, 0, ~

## $ S16M_D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, ~

## $ S16M_E <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S16M_F <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 1, 1, 1, 0, ~

## $ S16M_G <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_H <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_I <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_K <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_J <dbl+lbl> 1, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S17.A <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 1, 2, 1, 2, ~

## $ S17.B <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, 1, 1, 2, 2, 2, 1, 1, 1, 1, ~

## $ S17.C <dbl+lbl> 2, 1, 1, 1, 2, 2, 1, 2, 2, 2, 1, 2, 1, 2, 1, 1, ~

## $ S17.E <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, 2, 2, 1, 1, 1, 1, ~

## $ S17.F <dbl+lbl> 2, 1, 1, 2, 1, 2, 1, 2, 1, 2, 2, 1, 1, 2, 1, 1, ~

## $ S17.G <dbl+lbl> 1, 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S17.I <dbl+lbl> 2, 2, 1, 2, 2, 2, 1, 2, 1, 2, 2, 2, 1, 2, 1, 2, ~

## $ S17.J <dbl+lbl> 1, 1, 1, 2, 1, 2, 1, 1, 1, 2, 1, 1, 1, 2, 1, 1, ~

## $ S17.K <dbl+lbl> 1, 1, 2, 2, 1, 1, 1, 2, 1, 1, 2, 1, 1, 1, 1, 1, ~

## $ S17.L <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S17.M <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 1, 1, 1, 1, 1, ~

## $ S17.N <dbl+lbl> 1, 2, 1, 2, 2, 2, 2, 1, 2, 1, 1, 2, 1, 2, 1, 1, ~

## $ S18.A <dbl+lbl> 6, 3, 2, 1, 5, 1, 1, 6, 1, 1, 1, 2, 6, 6, 3, 4, ~

## $ S18.B <dbl+lbl> NA, NA, NA, NA, 7, NA, NA, NA, NA, NA, NA, NA, ~

## $ S19 <dbl+lbl> NA, 7, 5, 4, NA, 4, 2, NA, 4, 4, 4, 5, ~

## $ S20 <dbl+lbl> 9, NA, NA, NA, NA, NA, NA, 25, NA, 12, 20, NA, ~

## $ S20.A <dbl+lbl> 5, NA, NA, NA, NA, NA, NA, 3, NA, 1, 3, 2, ~

## $ S20.B <dbl+lbl> 8, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, NA, ~

## $ S21 <dbl+lbl> NA, NA, NA, NA, NA, NA, NA, 5, NA, 4, 8, 7, ~

## $ S22 <dbl+lbl> 3, 3, 1, 4, 2, 4, 2, 2, 5, 3, 4, 2, 1, 4, 2, 5, ~

## $ S23 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S24.A <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S24.B <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

df_latinobarometro2017_spss_2 <- df_latinobarometro2017_spss %>% clean_names()Ejercicio 4B

Ahora, repite el proceso de descarga de la base de datos de Stata (.dta).

df_latinobarometro2017_stata <- read_stata("00-archivos/ejercicios/capitulo 4/latinobarometro2017_dta/Latinobarometro2017Eng_v20180117.dta")

glimpse(df_latinobarometro2017_stata) # Notamos que hay etiquetas en las variables

## Rows: 20,200

## Columns: 324

## $ numinves <dbl+lbl> 2017, 2017, 2017, 2017, 2017, 2017, 2017, 2017, ~

## $ idenpa <dbl+lbl> 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, 32, ~

## $ numentre <dbl> 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 1~

## $ reg <dbl+lbl> 32301, 32301, 32301, 32301, 32301, 32301, 32301,~

## $ ciudad <dbl+lbl> 3.2e+07, 3.2e+07, 3.2e+07, 3.2e+07, 3.2e+07, 3.2~

## $ tamciud <dbl+lbl> 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, 7, ~

## $ comdist <dbl> 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 3, 3~

## $ codigo <dbl> 37, 43, 37, 43, 37, 43, 43, 37, 43, 37, 37, 43, 37, ~

## $ diareal <dbl+lbl> 29, 29, 29, 29, 29, 29, 29, 29, 4, 4, 4, 4, ~

## $ mesreal <dbl+lbl> 7, 7, 7, 7, 7, 7, 7, 7, 8, 8, 8, 8, 8, 8, 8, 8, ~

## $ ini <dbl> 1053, 1103, 1149, 1158, 1251, 1432, 1306, 1354, 1141~

## $ fin <dbl> 1128, 1146, 1227, 1241, 1346, 1505, 1351, 1422, 1212~

## $ dura <dbl> 35, 43, 38, 43, 55, 33, 45, 28, 31, 33, 27, 30, 37, ~

## $ totrevi <dbl> 0, 0, 1, 0, 0, 0, 2, 0, 0, 0, 0, 0, 1, 0, 0, 4, 0, 0~

## $ totcuot <dbl+lbl> 0, 1, 5, 0, 1, 1, 4, 0, 0, 0, 0, 0, 0, 1, 1, 0, ~

## $ totrech <dbl+lbl> 3, 1, 3, 1, 3, 0, 1, 0, 1, 0, 0, 0, 2, 1, 2, 3, ~

## $ totperd <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ numcasa <dbl+lbl> 4, 2, 4, 2, 4, 1, 2, 1, 2, 1, 1, 1, 3, 2, 3, 4, ~

## $ codsuper <dbl+lbl> 1, 1, 1, 1, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ supervvi <dbl+lbl> 1, 2, 1, 1, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ superven <dbl+lbl> 0, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ codif <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ digit <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ wt <dbl+lbl> 1.58, 0.71, 1.00, 0.71, 0.71, 0.71, 0.71, 0.71, ~

## $ P1ST <dbl+lbl> 3, 3, 1, 2, 2, 3, 1, 1, 1, 1, 1, 1, 1, 1, 1, 3, ~

## $ P2ST <dbl+lbl> 2, 2, -1, 1, 1, 3, 1, 2, 1, 2, 2, 3, ~

## $ P3STGBS <dbl+lbl> 7, 25, 6, 13, 6, 6, 13, 6, 15, 25, 25, 7, ~

## $ P4STGBSC <dbl+lbl> 4, 3, 3, 4, 2, 4, 3, 3, 2, 4, 3, 4, 3, 5, 3, 4, ~

## $ P5STGBS <dbl+lbl> 4, 4, 2, 4, 3, 5, 4, 4, 3, 4, 4, 4, 4, 4, 2, 5, ~

## $ P6STICC1 <dbl+lbl> 2, 2, 2, 2, 3, 4, 1, 4, 4, 4, -1, -1, ~

## $ P7STGBS <dbl+lbl> 3, 3, 1, 2, 3, 2, 2, 3, 2, 2, 2, 3, ~

## $ P8STGBS <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 1, 3, 2, 3, 1, ~

## $ P9STGBSC_A <dbl+lbl> 3, 3, 1, 3, 2, 2, 3, 1, 4, 1, 3, 2, ~

## $ P9STGBS_B <dbl+lbl> 3, 4, 3, 3, 2, 4, 3, 4, 2, 3, 3, 3, 4, 4, 4, 3, ~

## $ P10ST <dbl+lbl> 1, 1, 2, -1, 1, 1, 2, 1, 2, 2, 1, 1, ~

## $ P11STGBSC <dbl+lbl> 1, 6, 8, 6, 7, 6, 10, 5, 8, 7, 5, 10, ~

## $ P12STC <dbl+lbl> 16, 16, 1, 1, 1, 2, 1, 3, 97, 1, 3, 97, ~

## $ P13STGBS <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P14STGBS_A <dbl+lbl> 2, 4, 2, 1, 1, 3, 1, 3, 1, 3, 2, 2, 3, 3, 3, 3, ~

## $ P14STGBS_B <dbl+lbl> 2, 4, 2, 3, 3, 4, 2, 2, 4, 4, 3, 2, 4, 3, 3, 2, ~

## $ P14ST_C <dbl+lbl> -1, 3, 2, 1, 1, 1, 1, 1, 2, 2, 4, 2, ~

## $ P14ST_D <dbl+lbl> 2, 4, 3, 3, 3, 3, 3, 4, 4, 2, 1, 2, ~

## $ P14ST_E <dbl+lbl> 2, 4, 2, 1, 1, 4, 1, 2, 2, 4, 3, 3, 4, 4, 4, 4, ~

## $ P14ST_F <dbl+lbl> 2, 4, 2, 4, 1, 3, 2, 1, 4, 4, 2, 2, ~

## $ P14ST_G <dbl+lbl> 3, 3, 3, 4, 4, 4, 3, 4, 3, 4, 2, 2, 4, 4, 3, 3, ~

## $ P14ST_H <dbl+lbl> 2, 3, 2, 2, 3, 3, 1, 4, 4, 4, 3, 2, ~

## $ P15ST_A <dbl+lbl> 0, 0, 1, 1, 0, 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 1, ~

## $ P15ST_B <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P15ST_C <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST_D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, ~

## $ P15ST_E <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, ~

## $ P15ST_F <dbl+lbl> 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P15ST_G <dbl+lbl> 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, 0, 0, ~

## $ P15ST_H <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST_I <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 1, 1, 1, ~

## $ P15ST_J <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P15ST_K <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, ~

## $ P16STGBS <dbl+lbl> -1, 95, 32044, 32006, 32044, 32001, -1,~

## $ P16STGBS_A <dbl+lbl> -1, -1, 1, 1, 1, 2, -1, 2, 1, 2, -1, 2, ~

## $ perpart <dbl+lbl> 4, 4, 1, 1, 1, 2, 4, 2, 1, 2, 4, 2, 4, 4, 2, 2, ~

## $ fampart <dbl+lbl> 0, 0, 30, 60, 30, 30, 0, 30, 30, 30, 0, 30, ~

## $ P17STGBSC <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, ~

## $ P18GBS <dbl+lbl> 3, 3, 2, 3, 2, 5, 2, 1, 4, 2, 3, 2, 2, 3, 3, 3, ~

## $ P19STC <dbl+lbl> 0, 5, 8, -2, 8, 4, 5, 5, 5, 8, 5, 6, ~

## $ P20ST <dbl+lbl> 3, 3, -1, 3, 3, 3, 3, 3, 2, 3, 1, 3, ~

## $ P21ST_A <dbl+lbl> 1, 2, 2, 2, -1, 1, 2, 3, 4, 2, 2, 2, ~

## $ P21ST_B <dbl+lbl> 2, 2, 3, 3, 4, 2, 3, 2, -1, 2, 1, 2, ~

## $ P21ST_C <dbl+lbl> 1, 3, 1, 1, 2, 2, 2, 1, -1, 2, 2, 1, ~

## $ P21ST_D <dbl+lbl> 2, 2, 1, 1, 3, 2, 3, 1, 1, 2, 3, 2, 2, 3, 2, 2, ~

## $ P21ST_E <dbl+lbl> 2, 3, 3, 1, 3, 3, 3, 3, 4, 2, 2, 3, 2, 3, 2, 2, ~

## $ P21ST_F <dbl+lbl> 2, 2, 2, 2, -1, 3, 2, 2, 2, 2, 2, 3, ~

## $ P21ST_G <dbl+lbl> 2, 2, 1, 2, 4, 2, 3, 4, 2, 2, 2, 2, ~

## $ P21ST_H <dbl+lbl> 2, 3, 1, 1, 4, 2, 3, 2, 1, 2, 1, 1, 1, 2, 2, 2, ~

## $ P22ST <dbl+lbl> 4, 3, 1, 1, 1, 2, 1, 2, 3, 2, 3, 2, 2, 4, 2, 2, ~

## $ P23STC <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 2, 1, 1, 2, 1, 1, 2, 1, 4, ~

## $ P24STC <dbl+lbl> 2, 2, 1, 1, 1, 1, 3, -1, 1, 2, 2, 1, ~

## $ P25STTI <dbl+lbl> 2, 1, 1, 1, 1, 1, 2, 1, 1, 2, 4, 1, 2, 3, 1, 1, ~

## $ P26ST <dbl+lbl> 2, 2, 4, 4, 2, 2, 4, 4, 1, 2, 2, 2, 4, 3, 2, 1, ~

## $ P27ST <dbl+lbl> 2, 2, 1, 3, 1, 2, 1, 2, 2, 2, 2, 2, ~

## $ P28N_A <dbl+lbl> 8, 8, 8, 8, 8, 2, 1, 2, 2, 8, 2, 8, 8, 2, 8, 8, ~

## $ P28N_B <dbl+lbl> 8, 8, 2, 2, 8, 2, 1, 2, 2, 8, 2, 8, ~

## $ P28N_C <dbl+lbl> 2, 8, 8, 8, 8, 2, 2, 8, 8, 8, 2, 8, 8, 1, 8, 8, ~

## $ P28N_D <dbl+lbl> 8, 8, 8, 8, 8, 2, 8, 2, 2, 8, 2, 8, ~

## $ P28N_E <dbl+lbl> 8, 1, 2, 2, 2, 2, 2, 2, 2, 8, 2, 8, ~

## $ P28N_F <dbl+lbl> 8, 8, 2, 2, 2, 2, 2, 2, 2, 8, 2, 8, ~

## $ P29NSPA <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 1, 1, 1, 0, 1, 1, 0, ~

## $ P29NSPB <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P29NSPC <dbl+lbl> 0, 1, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, ~

## $ P29NSPD <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPE <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPF <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPG <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPH <dbl+lbl> 1, 1, 1, 1, 1, 1, 0, 1, 1, 0, 0, 0, 1, 1, 0, 0, ~

## $ P29NSPI <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 1, 0, ~

## $ P29NSPJ <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, ~

## $ P29NSPZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P29NSPX <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P30NSP <dbl+lbl> 10, 10, 8, 1, 9, 10, 5, 1, 1, 10, 10, 1, ~

## $ P31NSP <dbl+lbl> -3, -3, 1, 1, 3, -3, 1, 1, 1, -3, -3, 1, ~

## $ P32NSP_A <dbl+lbl> -3, -3, 2, 1, 1, -3, 1, 1, 1, -3, -3, 6, ~

## $ P33NSP <dbl+lbl> -3, -3, 1, 1, 1, -3, 1, 1, 1, -3, -3, 2, ~

## $ P34NA <dbl+lbl> -3, -3, -2, 1, 9, -3, -2, 24, -2, -3, -3, 1, ~

## $ P34NB <dbl+lbl> 99, 99, 10, 0, 0, 99, 15, 0, 20, 99, 99, 0, ~

## $ P35NC <dbl+lbl> 1, 1, 3, 2, 0, 1, 1, 1, 0, 2, 0, 3, ~

## $ P36C <dbl+lbl> 2, 1, 2, 1, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P37NC <dbl+lbl> -1, 2, 1, 2, 1, 1, 1, 1, 1, 2, 1, 1, ~

## $ P38ST <dbl+lbl> 4, 2, 1, 4, 1, 4, 2, 3, 2, 3, 1, 2, ~

## $ P39STTI <dbl+lbl> 3, 3, 4, 3, 4, 2, 3, 3, 4, 2, 2, 2, ~

## $ P40NC_A <dbl+lbl> 1, -3, 2, -3, 0, -3, 2, -3, 2, -3, 1, -3, ~

## $ P40NC_B <dbl+lbl> -3, 2, -3, 1, -3, 2, -3, 1, -3, 1, -3, 2, ~

## $ P41STC_A <dbl+lbl> 1, 5, 4, -1, 5, 5, 5, 4, 5, 4, 1, 4, ~

## $ P41STC_B <dbl+lbl> 2, 5, 4, -1, 5, 5, 3, 2, 5, 4, 1, 3, ~

## $ P41STC_C <dbl+lbl> 2, -1, 2, -1, 5, 5, 2, 2, 5, 4, 1, 3, ~

## $ P42NC_A <dbl+lbl> 5, 5, 7, 10, 7, 3, 7, 5, 10, 7, 6, 7, ~

## $ P42NC_B <dbl+lbl> 5, 6, 7, 4, 8, 1, 9, 5, 5, 6, 6, 8, ~

## $ P42NC_C <dbl+lbl> 2, 6, 8, 6, -1, 1, 9, 8, 2, 8, 0, 9, ~

## $ P42NC_D <dbl+lbl> 6, 6, 3, 10, 7, 10, 8, 5, 10, 8, 0, 8, ~

## $ P42NC_E <dbl+lbl> 6, 4, 5, 10, 8, 5, 4, 5, 10, 8, 0, 7, ~

## $ P42NC_F <dbl+lbl> 6, 4, 5, 10, 10, -1, 1, 7, 10, 7, 0, 7, ~

## $ P43ST_A <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 1, 4, 1, 1, 2, ~

## $ P43ST_B <dbl+lbl> 2, 1, 2, 1, 1, 2, 1, 1, 4, 1, 1, 2, ~

## $ P44N <dbl+lbl> 5, 3, 5, -1, 5, 5, 4, 2, 6, 3, 3, 5, ~

## $ P45ST_A <dbl+lbl> 2, 2, 2, 4, 2, 4, 3, 2, 2, 2, 2, 2, ~

## $ P45N_B <dbl+lbl> -1, 3, -1, -1, -1, -1, 3, -1, -1, -1, 2, -1, ~

## $ P45ST_C <dbl+lbl> 2, 2, 2, 2, 2, -1, 2, -1, 2, -1, 2, 2, ~

## $ P45ST_D <dbl+lbl> -1, -1, 1, 2, 2, -1, 1, -1, 3, -1, 2, -1, ~

## $ P45ST_E <dbl+lbl> -1, 2, 3, -1, -1, -1, 2, -1, 3, -1, 2, -1, ~

## $ P45N_F <dbl+lbl> 4, 3, -1, -1, -1, -1, 2, -1, 3, -1, 2, -1, ~

## $ P46ST_A <dbl+lbl> -1, 2, 2, 2, 1, 3, 2, -1, 2, 2, -1, 2, ~

## $ P46ST_B <dbl+lbl> -1, 3, -1, -1, 3, -1, 2, -1, -1, -1, -1, -1, ~

## $ P46ST_C <dbl+lbl> 2, 3, 2, -1, 2, -1, 1, -1, 2, -1, -1, -1, ~

## $ P46ST_D <dbl+lbl> 2, 3, 2, 2, 3, -1, 2, -1, 3, -1, -1, -1, ~

## $ P46STM_E <dbl+lbl> -1, 4, -1, -1, 3, -1, 3, -1, 3, -1, -1, -1, ~

## $ P47N <dbl+lbl> 2, 3, 1, 3, 2, 4, 1, 1, 1, 3, 3, 3, ~

## $ P48STM <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, -1, 2, 2, -1, 1, ~

## $ P49STA_1 <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 1, 2, 1, 1, 1, 2, 1, 2, ~

## $ P49STA_2 <dbl+lbl> 2, 2, 1, 2, 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA_3 <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA_4 <dbl+lbl> 1, 1, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA_5 <dbl+lbl> 2, 2, 2, 2, 2, 1, 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, ~

## $ P49STA_6 <dbl+lbl> 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P49STA_7 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 2, 1, 2, 1, 1, 2, 2, 1, 2, ~

## $ P49STA_8 <dbl+lbl> 2, 1, 1, 1, 1, 2, 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, ~

## $ P49STB_1 <dbl+lbl> -1, 2, 2, 3, 3, -1, 1, -1, 2, -1, 2, 1, ~

## $ P49STB_2 <dbl+lbl> -1, -1, 2, -1, 1, -1, 3, -1, 2, -1, -1, -1, ~

## $ P49STB_3 <dbl+lbl> -1, -1, -1, -1, -1, -1, -1, -1, -1, -1, -1, -1, ~

## $ P49STB_4 <dbl+lbl> 2, 2, -1, 3, 1, -1, 2, -1, -1, -1, -1, -1, ~

## $ P49STB_5 <dbl+lbl> -1, -1, -1, -1, -1, -1, -1, -1, -1, -1, 2, -1, ~

## $ P49STB_6 <dbl+lbl> -1, -1, -1, -1, 1, -1, -1, -1, -1, -1, -1, -1, ~

## $ P49STB_7 <dbl+lbl> 2, 4, 2, 4, 3, -1, 3, -1, 4, -1, 1, 2, ~

## $ P49STB_8 <dbl+lbl> -1, 4, 2, 4, 3, -1, 3, -1, -1, -1, 1, -1, ~

## $ P50STM <dbl+lbl> -1, 4, 1, 1, 2, 97, 4, -1, 7, -1, -1, -1, ~

## $ P51STMA <dbl+lbl> 0, 1, 0, 1, 1, 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, ~

## $ P51STMB <dbl+lbl> 1, 1, 1, 0, 1, 1, 1, 0, 1, 0, 1, 1, 1, 1, 0, 1, ~

## $ P51STMC <dbl+lbl> 0, 0, 1, 1, 1, 0, 1, 1, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMD <dbl+lbl> 0, 0, 1, 1, 1, 0, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STME <dbl+lbl> 0, 0, 0, 1, 1, 0, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, ~

## $ P51STMF <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, ~

## $ P51STMG <dbl+lbl> 0, 0, 0, 1, 1, 1, 1, 0, 1, 0, 0, 1, 1, 1, 0, 0, ~

## $ P51STMH <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMI <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMJ <dbl+lbl> 0, 0, 1, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMK <dbl+lbl> 0, 1, 0, 1, 0, 1, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P51STMZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NA <dbl+lbl> 1, 0, 1, 1, 0, 0, 1, 1, 0, 1, 1, 1, 1, 0, 1, 1, ~

## $ P52NB <dbl+lbl> 0, 1, 0, 0, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NC <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52ND <dbl+lbl> 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P52NE <dbl+lbl> 0, 0, 0, 1, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52NF <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, ~

## $ P52NZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, ~

## $ P53ST_A <dbl+lbl> 2, 2, 2, 2, 1, 2, 1, 1, 2, 1, 1, 3, ~

## $ P53N_B <dbl+lbl> 2, 3, 1, 2, 2, 2, 3, 4, 1, 2, 2, 2, ~

## $ P53N_C <dbl+lbl> 2, 3, 3, -1, 4, 2, 3, 4, 3, 4, -1, 3, ~

## $ P53N_D <dbl+lbl> 1, 3, 3, 1, 2, 2, 4, 4, 3, 1, 4, 4, ~

## $ P53N_E <dbl+lbl> 2, 2, 2, 2, 1, 1, 1, 1, 2, 1, 2, 2, ~

## $ P53N_F <dbl+lbl> 2, 2, 1, 1, 2, 2, 3, 4, 2, 1, 2, 3, ~

## $ P53N_G <dbl+lbl> 2, 2, 1, 1, 2, 2, 3, 4, 2, 1, 2, 3, ~

## $ P53N_H <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 4, 1, 1, 2, 1, ~

## $ P53N_I <dbl+lbl> 1, 1, 1, 1, 1, 3, 1, 1, 1, 1, 4, 1, ~

## $ P54STMA <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ P54STMB <dbl+lbl> 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P54STMC <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, ~

## $ P54STMD <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STME <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMF <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMG <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ P54STMH <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMI <dbl+lbl> 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMJ <dbl+lbl> 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMX <dbl+lbl> 1, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P54STMZ <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P55N_A <dbl+lbl> 1, 2, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ P55N_B <dbl+lbl> 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P55N_C <dbl+lbl> 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P56N_A <dbl+lbl> 1, 2, 1, 1, 1, 3, 3, 4, 1, 1, 2, 2, 1, 1, 1, 1, ~

## $ P56N_B <dbl+lbl> 1, 2, 3, 1, 1, 1, 3, 4, 1, 1, 1, 3, 1, 1, 1, 1, ~

## $ P56N_C <dbl+lbl> 1, 2, 1, 1, 1, 2, 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, ~

## $ P56N_D <dbl+lbl> 1, 2, 1, 2, 1, 2, 3, 1, 1, 1, 1, 1, ~

## $ P56N_E <dbl+lbl> 1, 2, 1, 1, 1, 1, 1, 4, 1, 1, 1, 2, 1, 1, 1, 4, ~

## $ P56N_F <dbl+lbl> 2, 2, 1, 2, 2, 2, 1, 1, 2, 1, 1, 2, ~

## $ P56N_G <dbl+lbl> 1, 3, 1, 2, 1, 2, -1, 1, 2, 2, 1, 3, ~

## $ P57N <dbl+lbl> 2, 1, 1, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 1, 2, ~

## $ P58N <dbl+lbl> 2, 2, 1, 2, 2, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ P59N <dbl+lbl> -1, 1, 1, 1, 1, 2, 2, 1, 1, 1, 1, 1, ~

## $ P60N <dbl+lbl> 1, 1, 1, 1, 1, 2, 1, 2, 1, 2, 2, 1, ~

## $ P61ST_1 <dbl+lbl> -1, 5, 5, 4, -1, 1, 2, -1, 1, 8, -6, 8, ~

## $ P61ST_2 <dbl+lbl> 0, 4, 0, 0, 4, 0, 4, 8, 0, -6, -1, 2, ~

## $ P61ST_3 <dbl+lbl> 10, 7, 9, 9, 8, 10, 10, 10, 2, 8, -6, 10, ~

## $ P62NA <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 0, 0, 1, 1, 0, 1, 0, 0, 0, ~

## $ P62NB <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, ~

## $ P62NC <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 1, 1, 1, 0, 1, 1, 1, 1, 1, ~

## $ P62ND <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, ~

## $ P62NE <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 0, 1, 1, 0, 1, 0, 0, 0, 0, ~

## $ P62NF <dbl+lbl> 0, 0, 0, 1, 1, 0, 0, 0, 0, 1, 0, 0, 1, 1, 0, 0, ~

## $ P62NG <dbl+lbl> 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 0, 1, 1, 0, 0, 0, ~

## $ P62NH <dbl+lbl> 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, ~

## $ P62NI <dbl+lbl> 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NJ <dbl+lbl> 1, 1, 1, 0, 0, 0, 1, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P62NK <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, ~

## $ P62NX <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NY <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P62NZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63A <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63B <dbl+lbl> 0, 1, 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63C <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P63D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63E <dbl+lbl> 0, 0, 1, 0, 1, 1, 1, 1, 0, 0, 0, 0, 0, 1, 1, 0, ~

## $ P63F <dbl+lbl> 0, 0, 0, 0, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63G <dbl+lbl> 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63H <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63I <dbl+lbl> 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, ~

## $ P63J <dbl+lbl> 0, 0, 1, 0, 1, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63K <dbl+lbl> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, 0, ~

## $ P63X <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P63Y <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, ~

## $ P63Z <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STAA <dbl+lbl> 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P64STAB <dbl+lbl> 0, 0, 1, 1, 1, 1, 1, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P64STAC <dbl+lbl> 0, 0, 0, 1, 1, 1, 1, 0, 0, 0, 0, 1, 1, 1, 0, 1, ~

## $ P64STAD <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 1, 1, 0, 0, 1, 1, 1, 0, 1, ~

## $ P64STAE <dbl+lbl> 1, 0, 0, 1, 1, 1, 1, 1, 1, 0, 0, 1, 1, 0, 0, 0, ~

## $ P64STAF <dbl+lbl> 0, 0, 1, 1, 0, 1, 0, 1, 0, 0, 0, 1, 1, 1, 1, 1, ~

## $ P64STAG <dbl+lbl> 0, 1, 0, 1, 1, 0, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, ~

## $ P64STAH <dbl+lbl> 0, 0, 0, 1, 1, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, ~

## $ P64STAZ <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBA <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBB <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBC <dbl+lbl> 1, 0, 0, 1, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, ~

## $ P64STBD <dbl+lbl> 1, 1, 1, 1, 1, 0, 1, 1, 1, 0, 1, 0, 0, 0, 1, 0, ~

## $ P64STBE <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBF <dbl+lbl> 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, ~

## $ P64STBG <dbl+lbl> 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBH <dbl+lbl> 1, 1, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ P64STBZ <dbl+lbl> 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 1, 1, 0, 0, ~

## $ P65ST_A <dbl+lbl> 4, 4, 1, 4, 4, 4, 1, 1, 2, 1, 4, 4, 4, 2, 4, 4, ~

## $ P65ST_B <dbl+lbl> 4, 4, 4, 4, 4, 4, 1, 4, 2, 4, 4, 4, 4, 2, 4, 4, ~

## $ P66ST <dbl+lbl> 1, 1, 1, 1, 1, 1, 2, 1, 1, 1, 4, 1, 1, 1, 1, 1, ~

## $ P67NBCS <dbl+lbl> 3, 3, 2, -1, 2, 2, 2, 4, -1, 1, 3, -1, ~

## $ P68NBCS <dbl+lbl> 1, 1, 2, 2, 1, 2, 2, 1, 2, 2, 2, 2, 1, 2, 1, 2, ~

## $ P69NBCS <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 2, 1, 1, 3, 1, 4, 1, 2, ~

## $ P70N_A <dbl+lbl> 0, -3, 1, -3, 0, -3, 2, -3, 1, -3, 0, -3, ~

## $ P70N_B <dbl+lbl> -3, 0, -3, 2, -3, 1, -3, 1, -3, 0, -3, 3, ~

## $ P71N <dbl+lbl> 2, 2, 1, 1, 1, 2, 1, 2, 2, 2, 1, 1, ~

## $ P72NR <dbl+lbl> 1, 4, 2, 4, 1, 4, 2, 1, 5, 4, 4, 3, 4, 4, 4, 4, ~

## $ P73NR <dbl+lbl> 1, 4, 2, 4, 1, 4, 1, 1, 5, 4, 4, 2, ~

## $ P74NR <dbl+lbl> 1, 1, -1, 1, -1, 4, 1, 4, 5, 5, 4, 5, ~

## $ P75NR <dbl+lbl> 4, 4, 4, 4, 4, 4, 5, 5, 3, 4, 4, 5, ~

## $ P76NR <dbl+lbl> 3, 1, 3, 2, 3, 4, 1, 1, 3, 4, 4, 4, 4, 4, 4, 5, ~

## $ sexo <dbl+lbl> 2, 1, 2, 2, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ S1 <dbl+lbl> 3, 4, 3, 4, 4, 5, 4, 3, 3, 3, 3, 4, 3, 3, 3, 3, ~

## $ edad <dbl> 61, 39, 38, 48, 67, 45, 48, 22, 42, 33, 22, 22, 26, ~

## $ S2 <dbl+lbl> 2, 2, 2, 1, 2, 1, 2, 1, 2, 1, 1, 1, 2, 1, 2, 2, ~

## $ S3 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S4 <dbl+lbl> 5, 2, 4, 4, 5, 2, 4, 5, 4, 2, 2, 1, 5, 5, 1, 5, ~

## $ S5 <dbl+lbl> 2, 2, 2, 3, 2, 4, 2, 2, 1, 2, 2, 3, 2, 4, 2, 2, ~

## $ S6 <dbl+lbl> 1, 1, 1, 3, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, ~

## $ S7 <dbl+lbl> 2e+07, 2e+07, 2e+07, 2e+07, 2e+07, 2e+07, 2e+07,~

## $ S8 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S9 <dbl+lbl> 12, 1, 97, 2, 1, 1, 1, 97, 1, 97, 97, 1, ~

## $ S9_A <dbl+lbl> -3, 4, -3, 2, 2, 2, 3, -3, 4, -3, -3, 2, ~

## $ S10 <dbl+lbl> 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, 6, ~

## $ S11 <dbl+lbl> -1, 2, 2, 1, 2, 2, 2, 2, 2, 2, 2, 2, ~

## $ S12 <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 2, 1, 2, 2, 2, 2, 2, 1, 2, ~

## $ S13 <dbl+lbl> 13, 30, 21, 16, 17, 35, 15, 19, 14, 21, -7, 22, ~

## $ S14 <dbl+lbl> 8, 13, 17, 9, 10, 13, 11, 12, 10, 13, 12, 17, ~

## $ REEDUC_1 <dbl+lbl> 3, 5, 7, 4, 4, 5, 4, 4, 4, 5, 4, 7, 5, 3, 5, 2, ~

## $ S15 <dbl+lbl> 1, 8, 10, -1, 3, 4, 13, 13, -1, 8, 1, 13, ~

## $ REEDUC_2 <dbl+lbl> 1, 3, 4, -2, 2, 2, 5, 5, -2, 3, 1, 5, ~

## $ reedad <dbl+lbl> 4, 2, 2, 3, 4, 3, 3, 1, 3, 2, 1, 1, 2, 1, 2, 1, ~

## $ S16M_A <dbl+lbl> 0, 1, 1, 1, 0, 0, 0, 1, 0, 1, 1, 1, 1, 0, 1, 1, ~

## $ S16M_B <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, ~

## $ S16M_C <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 0, 0, 0, 0, 1, 1, 1, 1, 0, ~

## $ S16M_D <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, ~

## $ S16M_E <dbl+lbl> 0, 1, 1, 1, 0, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S16M_F <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 1, 1, 1, 0, ~

## $ S16M_G <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_H <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_I <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_K <dbl+lbl> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S16M_J <dbl+lbl> 1, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ~

## $ S17_A <dbl+lbl> 2, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 2, 1, 2, 1, 2, ~

## $ S17_B <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, 1, 1, 2, 2, 2, 1, 1, 1, 1, ~

## $ S17_C <dbl+lbl> 2, 1, 1, 1, 2, 2, 1, 2, 2, 2, 1, 2, 1, 2, 1, 1, ~

## $ S17_E <dbl+lbl> 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, 2, 2, 1, 1, 1, 1, ~

## $ S17_F <dbl+lbl> 2, 1, 1, 2, 1, 2, 1, 2, 1, 2, 2, 1, 1, 2, 1, 1, ~

## $ S17_G <dbl+lbl> 1, 1, 1, 1, 2, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S17_I <dbl+lbl> 2, 2, 1, 2, 2, 2, 1, 2, 1, 2, 2, 2, 1, 2, 1, 2, ~

## $ S17_J <dbl+lbl> 1, 1, 1, 2, 1, 2, 1, 1, 1, 2, 1, 1, 1, 2, 1, 1, ~

## $ S17_K <dbl+lbl> 1, 1, 2, 2, 1, 1, 1, 2, 1, 1, 2, 1, 1, 1, 1, 1, ~

## $ S17_L <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S17_M <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 2, 1, 1, 1, 1, 1, ~

## $ S17_N <dbl+lbl> 1, 2, 1, 2, 2, 2, 2, 1, 2, 1, 1, 2, 1, 2, 1, 1, ~

## $ S18_A <dbl+lbl> 6, 3, 2, 1, 5, 1, 1, 6, 1, 1, 1, 2, 6, 6, 3, 4, ~

## $ S18_B <dbl+lbl> -3, -3, -3, -3, 7, -3, -3, -3, -3, -3, -3, -3, ~

## $ S19 <dbl+lbl> -3, 7, 5, 4, -3, 4, 2, -3, 4, 4, 4, 5, ~

## $ S20 <dbl+lbl> 9, -3, -3, -3, -3, -3, -3, 25, -3, 12, 20, -7, ~

## $ S20_A <dbl+lbl> 5, -3, -3, -3, -3, -3, -3, 3, -3, 1, 3, 2, ~

## $ S20_B <dbl+lbl> 8, -3, -3, -3, -3, -3, -3, -3, -3, -3, -3, -3, ~

## $ S21 <dbl+lbl> -3, -3, -3, -3, -3, -3, -3, 5, -3, 4, 8, 7, ~

## $ S22 <dbl+lbl> 3, 3, 1, 4, 2, 4, 2, 2, 5, 3, 4, 2, 1, 4, 2, 5, ~

## $ S23 <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S24_A <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

## $ S24_B <dbl+lbl> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, ~

df_latinobarometro2017_stata_2 <- df_latinobarometro2017_stata %>% clean_names()Capítulo 5: Modelos lineales

Paquetes y carga de datos

library(tidyverse)

library(paqueteadp)

library(skimr)

library(car)

## install.packages("ggcorrplot")

library(ggcorrplot)

## install.packages("texreg")

library(texreg)

## install.packages("prediction")

library(prediction)

## install.packages("lmtest")

library(lmtest)

## install.packages("sandwich")

library(sandwich)

## install.packages("miceadds")

library(miceadds)

data("bienestar")Ejercicio 5A

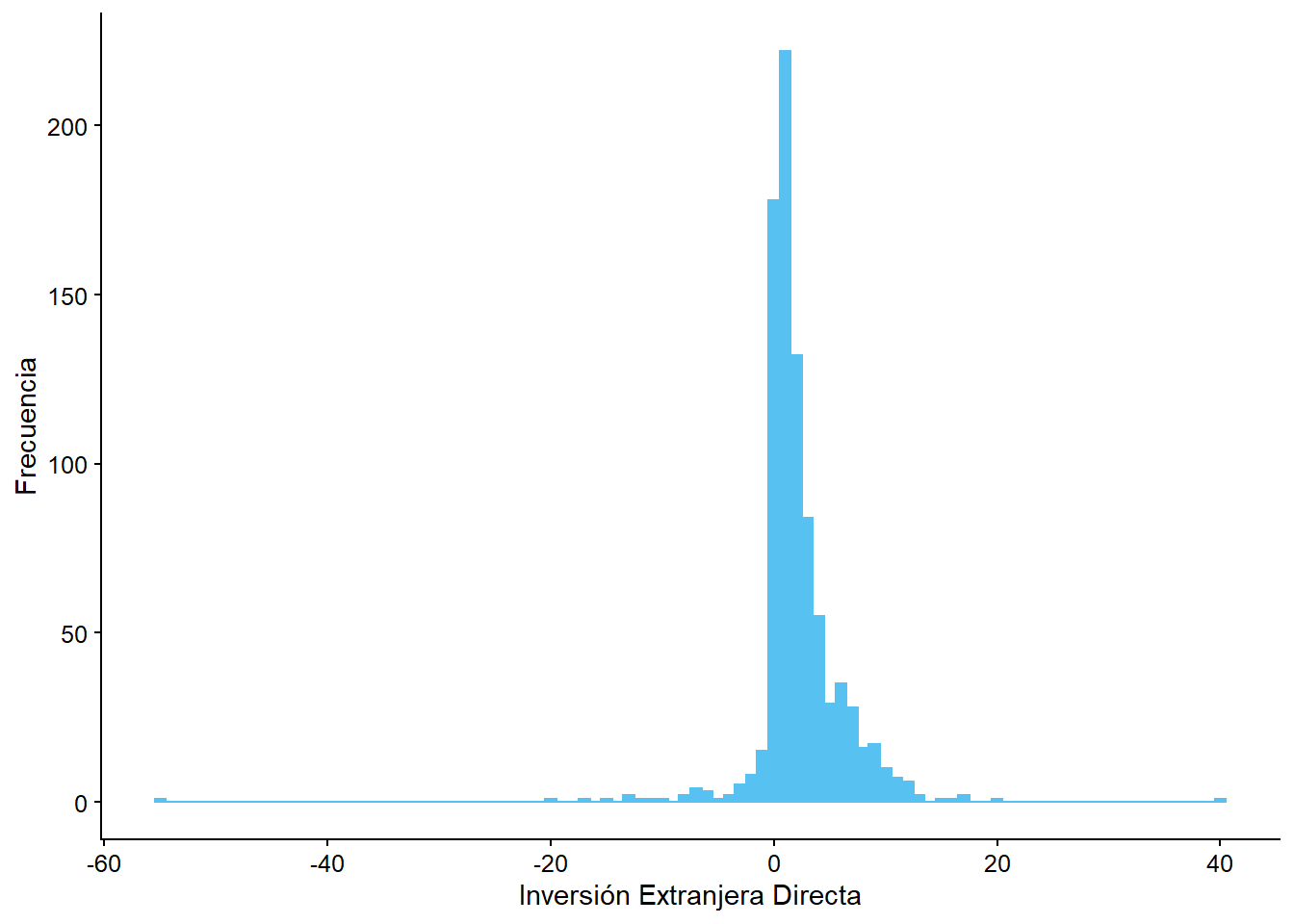

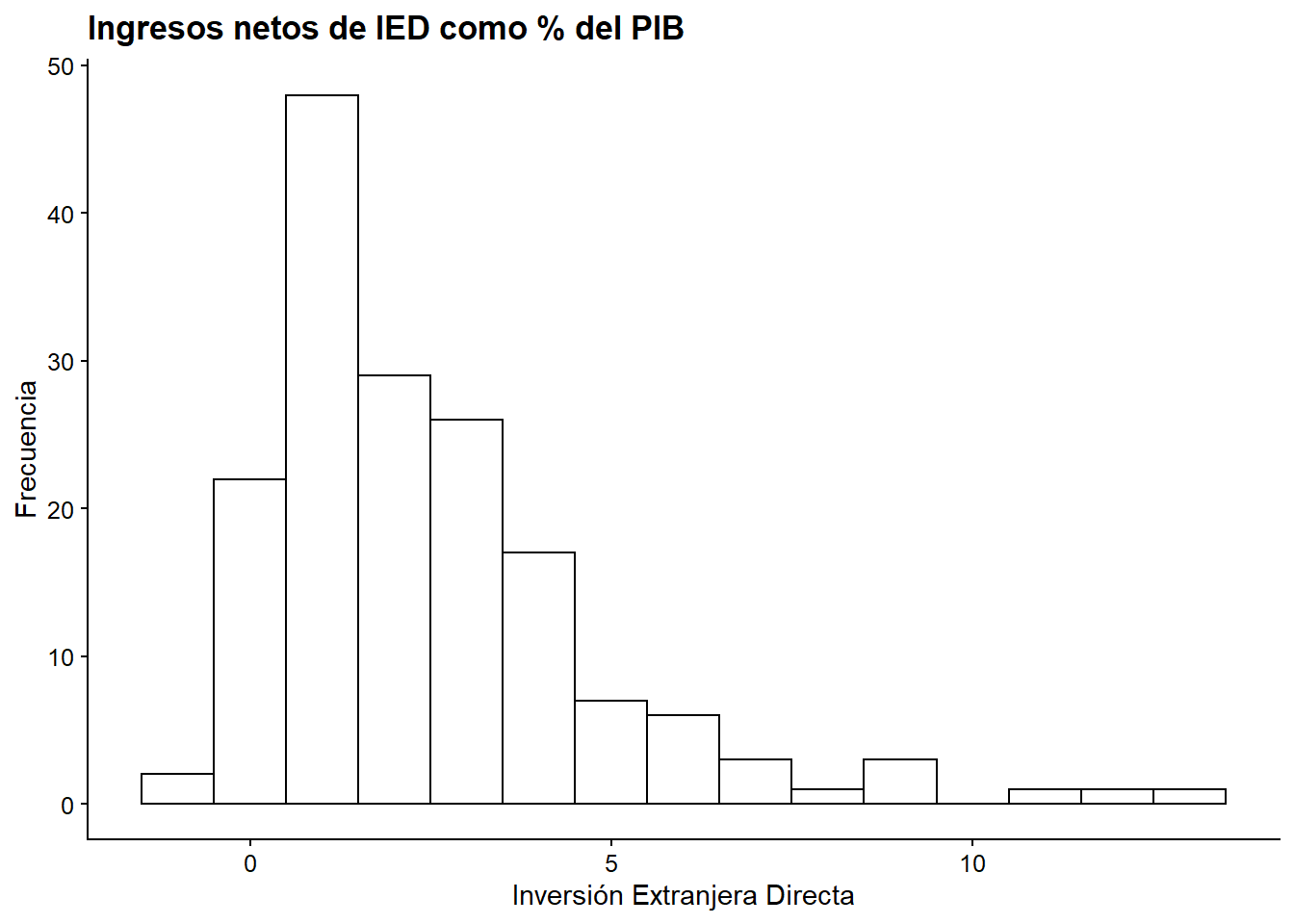

Imagina que ahora estamos interesados en el efecto de la Inversión Extranjera Directa

inversion_extranjeraen la desigualdad económica (Gini). Analiza la distribución de esta variable y haga un gráfico para evaluar la relación entre esta variable y nuestra variable independiente (gini), ¿Hay algún signo de correlación entre las variables? ¿Cuál es la dirección (positiva/negativa) de la relación?

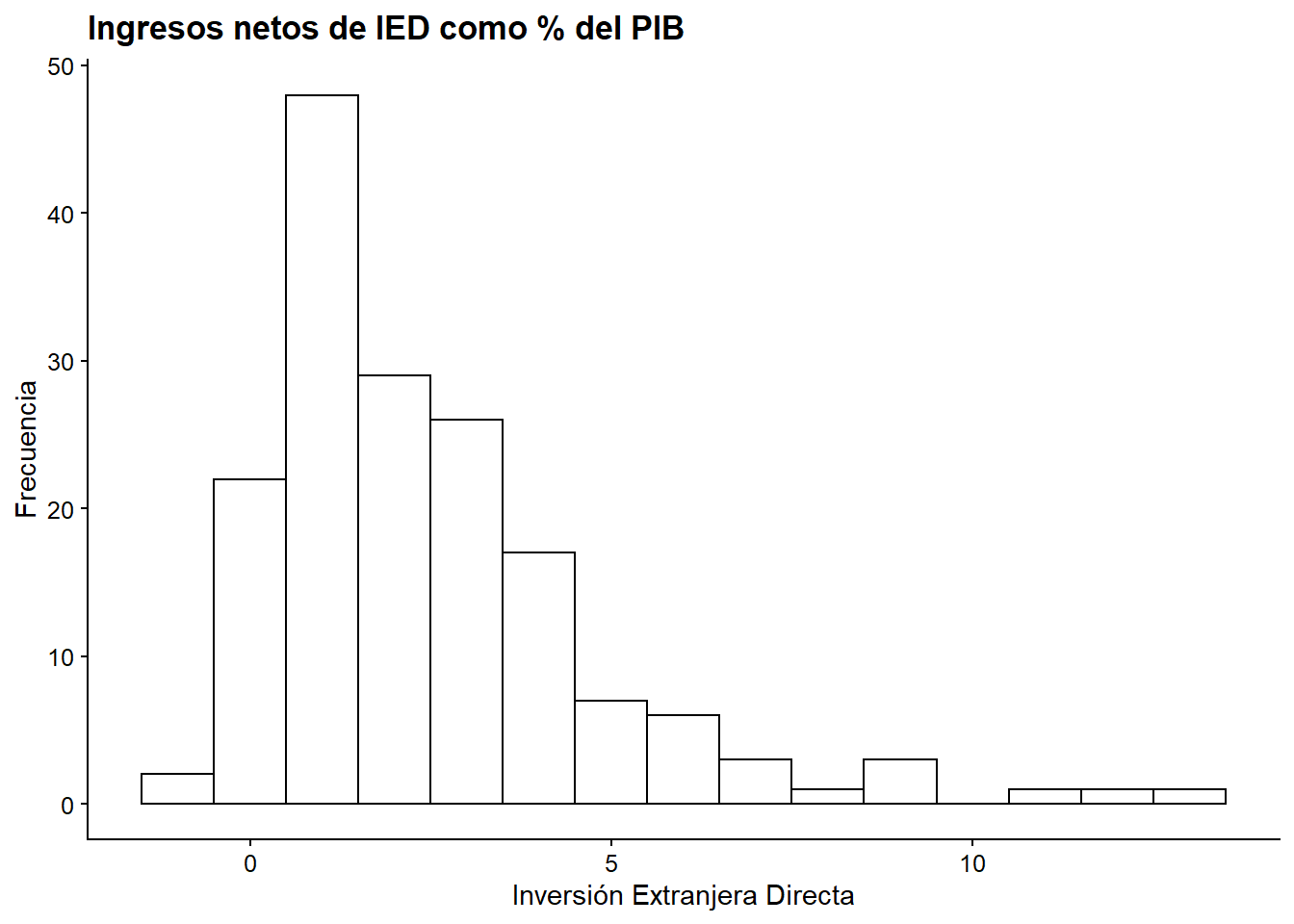

ggplot(bienestar, aes(x = inversion_extranjera)) +

geom_histogram(binwidth = 1) +

labs(x = "Inversión Extranjera Directa",

y = "Frecuencia")

Interpretación: Del gráfico se aprecia que los datos se concentran entre -10 y 15% de la Inversión Extranjera Directa, en el eje X. La curva estálevemente sesgada hacia la izquierda, con una alta frecuencia de observaciones cuando la IED es pequeña (aproximadamente entre 0 y 5%). Se pueden ver también valores atípicos, uno cercano al -60% y otro al 40% de la IED.

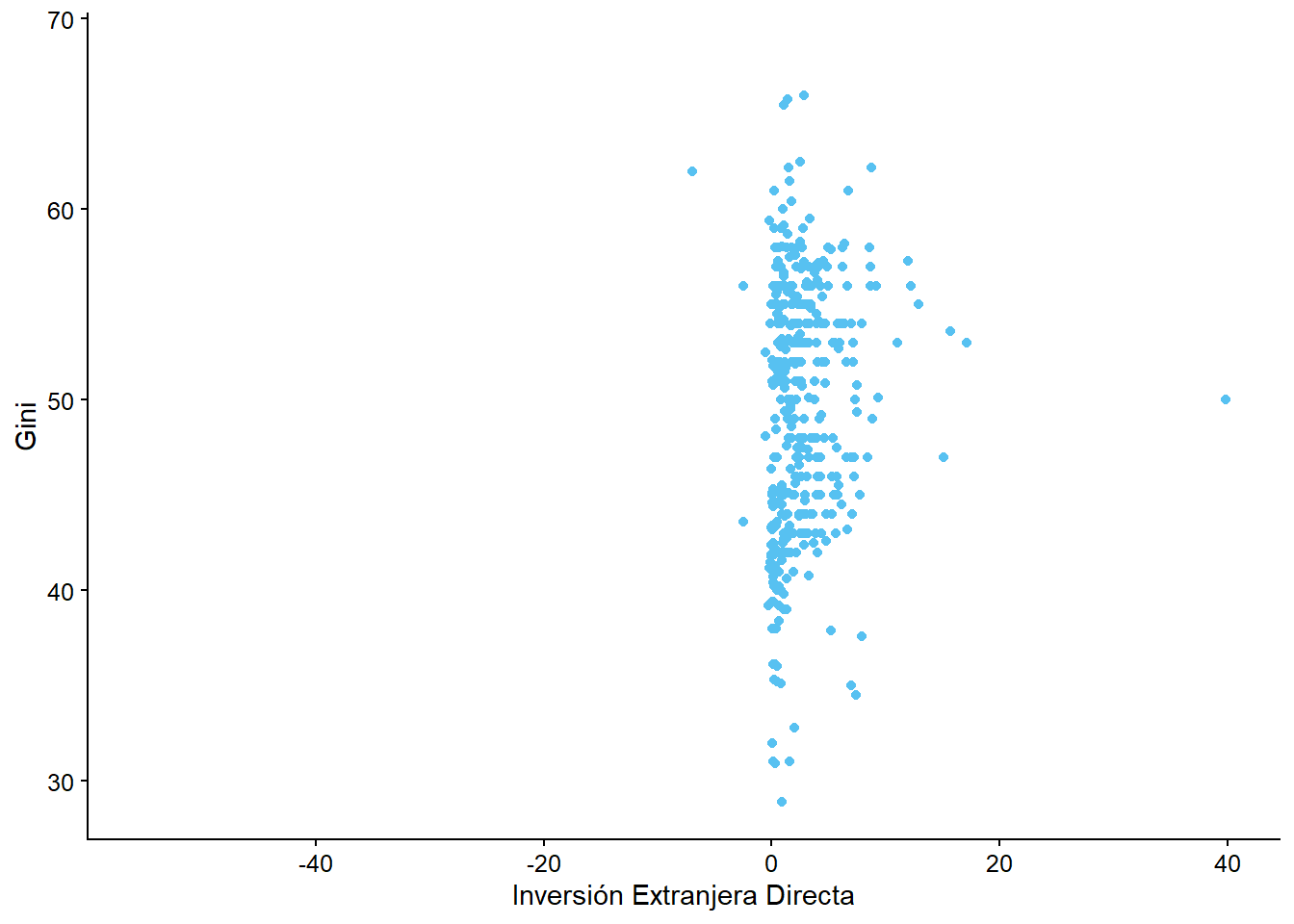

ggplot(bienestar, aes(x = inversion_extranjera, y = gini)) +

geom_point() +

labs(x = "Inversión Extranjera Directa",

y = "Gini")

## Warning: Removed 665 rows containing missing values (geom_point).

Interpretación: Es difícil ver una correlación clara entre las variables de desigualdad económica e inversión extranjera directa. Esto, debido a que los puntos están repartidos verticualmente cerca del valor 0 del eje X.

Ejercicio 5B

Utilizando los mismos datos, estima un modelo donde la variable independiente es Inversión Extranjera Directa (inversion_extranjera) y la variable dependiente es Desigualdad (gini) y exportarlo a un archivo .doc. ¿Es el efecto estadísticamente significativo?

modelo_ied <- lm(gini ~ 1 + inversion_extranjera, data = bienestar)screenreg(modelo_ied,

file = "modelo_1.doc",

custom.header = list("Gini" = 1),

custom.model.names = "Modelo 1",

custom.coef.names = c("Constante", "Inversión extranjera directa"),

custom.gof.names = c("R^2", "R^2 Ajustado", "Nro. Observaciones"),

doctype = T)| Gini | |

|---|---|

| Modelo 1 | |

| Constante | 48.75*** |

| (0.42) | |

| Inversión extranjera directa | 0.26** |

| (0.10) | |

| R^2 | 0.02 |

| R^2 Ajustado | 0.01 |

| Nro. Observaciones | 409 |

| ***p < 0.001; **p < 0.01; *p < 0.05 | |

El efecto de la inversión extranjera directa sobre el Gini es estadísticamente significativo, a un nivel de confianza de 99%. Esto implicaría que un aumento en 1% de la IED tendría como efecto el aumento de 0.26 puntos en el índice de Gini de un país.

Ejercicio 5C

Recuerda: incluir el 1 no es necesario para estimar el modelo (lo colocamos ahí sólo para recordarte que también estamos estimando la intercepción). Intente probar el modelo sin él, y verá que los resultados no cambian.

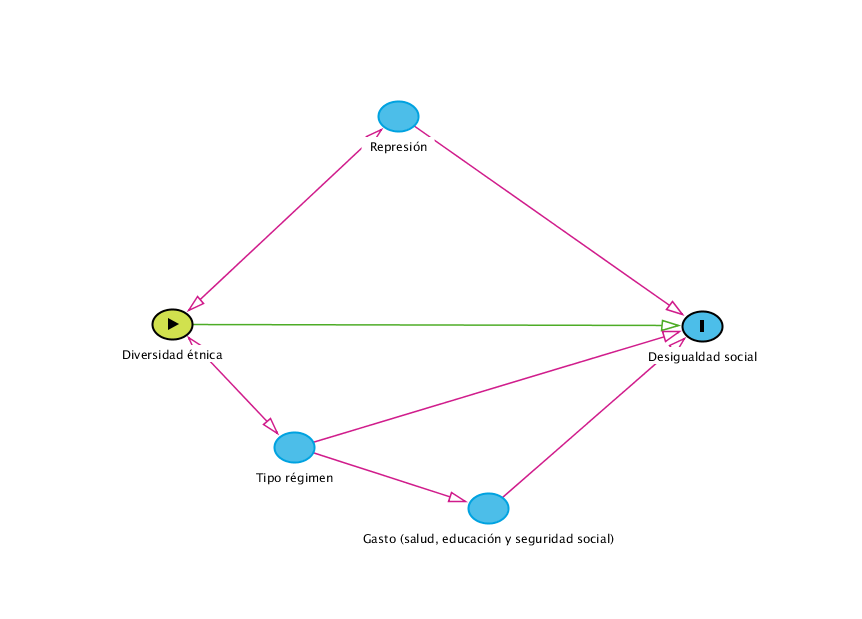

Modelo original

modelo_2 <- lm(gini ~ 1 + gasto_educ + inversion_extranjera + gasto_salud + gasto_segsocial +

poblacion + dualismo_sectorial + diversidad_etnica + pib +

factor(tipo_regimen) + bal_legislativo,

data = bienestar_no_na)Modelo sin + 1

modelo_2_v2 <- lm(gini ~ gasto_educ + inversion_extranjera + gasto_salud + gasto_segsocial +

poblacion + dualismo_sectorial + diversidad_etnica + pib +

factor(tipo_regimen) + bal_legislativo,

data = bienestar_no_na)Si vemos ambos modelos en una misma tabla notamos que todos los valores coinciden!

screenreg(list(modelo_2, modelo_2_v2),

custom.header = list("Gini" = 1:2),

custom.model.names = c("Modelo original", "Modelo sin +1"),

custom.coef.names = c("Constante", "Gasto educación", "Inversión extranjera directa", "Gasto Salud", "Gasto seguridad social", "Población joven", "Dualismo en economía", "Diversidad étnica", "PIB p/c", "Régimen democrático", "Régimen mixto", "Régimen Autoritario", "Balance poderes estado"),

custom.gof.names = c("R^2", "R^2 Ajustado", "Nro. Observaciones"))| Gini | ||

|---|---|---|

| Modelo original | Modelo sin +1 | |

| Constante | 85.94*** | 85.94*** |

| (8.73) | (8.73) | |

| Gasto educación | 1.59*** | 1.59*** |

| (0.45) | (0.45) | |

| Inversión extranjera directa | 0.24 | 0.24 |

| (0.18) | (0.18) | |

| Gasto Salud | -0.83** | -0.83** |

| (0.26) | (0.26) | |

| Gasto seguridad social | -0.83*** | -0.83*** |

| (0.20) | (0.20) | |

| Población joven | -0.93*** | -0.93*** |

| (0.17) | (0.17) | |

| Dualismo en economía | -0.17*** | -0.17*** |

| (0.03) | (0.03) | |

| Diversidad étnica | 3.68*** | 3.68*** |

| (1.04) | (1.04) | |

| PIB p/c | -0.00** | -0.00** |

| (0.00) | (0.00) | |

| Régimen democrático | -2.29 | -2.29 |

| (4.75) | (4.75) | |

| Régimen mixto | -2.90 | -2.90 |

| (4.70) | (4.70) | |

| Régimen Autoritario | -5.14 | -5.14 |

| (4.62) | (4.62) | |

| Balance poderes estado | -10.40*** | -10.40*** |

| (2.22) | (2.22) | |

| R^2 | 0.59 | 0.59 |

| R^2 Ajustado | 0.56 | 0.56 |

| Nro. Observaciones | 167 | 167 |

| ***p < 0.001; **p < 0.01; *p < 0.05 | ||

Ejercicio 5D

Exporta la tabla con ambos modelos (con y sin controles) a un archivo .doc, te esperamos.

modelo_1 <- lm(gini ~ 1 + gasto_educ, data = bienestar)

modelos <- list(modelo_1, modelo_2)screenreg(modelos,

custom.model.names = c("Modelo 1", "Modelo 2"),

custom.coef.names = c(

"Constante", "Gasto en educación", "IED",

"Gasto en salud", "Gasto en seg. social",

"Población jóven", "Dualismo en economía",

"División étnica", "PBI pc", "Reg. democrático", "Reg. mixto",

"Reg. autoritario", "Balance entre poderes"),

file = "modelos_capitulo5.doc", doctype = T)| Modelo 1 | Modelo 2 | |

|---|---|---|

| Constante | 44.81*** | 85.94*** |

| (1.02) | (8.73) | |

| Gasto en educación | 1.23*** | 1.59*** |

| (0.25) | (0.45) | |

| IED | 0.24 | |

| (0.18) | ||

| Gasto en salud | -0.83** | |

| (0.26) | ||

| Gasto en seg. social | -0.83*** | |

| (0.20) | ||

| Población jóven | -0.93*** | |

| (0.17) | ||

| Dualismo en economía | -0.17*** | |

| (0.03) | ||

| División étnica | 3.68*** | |

| (1.04) | ||

| PBI pc | -0.00** | |

| (0.00) | ||

| Reg. democrático | -2.29 | |

| (4.75) | ||

| Reg. mixto | -2.90 | |

| (4.70) | ||

| Reg. autoritario | -5.14 | |

| (4.62) | ||

| Balance entre poderes | -10.40*** | |

| (2.22) | ||

| R2 | 0.06 | 0.59 |

| Adj. R2 | 0.06 | 0.56 |

| Num. obs. | 356 | 167 |

| ***p < 0.001; **p < 0.01; *p < 0.05 | ||

Ejercicio 5E

Estime un modelo en el que excluya el gasto en salud (

gasto_salud) y el gasto en seguridad social (gasto_segsocial), y compare su capacidad explicativa con el modelo completo. De acuerdo con los resultados, ¿deberíamos excluir estas variables del modelo?

modelo_2restringido <- lm(gini ~ gasto_educ + inversion_extranjera +

poblacion + dualismo_sectorial + diversidad_etnica + pib +

factor(tipo_regimen) + bal_legislativo,

data = bienestar_no_na)

anova(modelo_2, modelo_2restringido)

## Analysis of Variance Table

##

## Model 1: gini ~ 1 + gasto_educ + inversion_extranjera + gasto_salud +

## gasto_segsocial + poblacion + dualismo_sectorial + diversidad_etnica +

## pib + factor(tipo_regimen) + bal_legislativo

## Model 2: gini ~ gasto_educ + inversion_extranjera + poblacion + dualismo_sectorial +

## diversidad_etnica + pib + factor(tipo_regimen) + bal_legislativo

## Res.Df RSS Df Sum of Sq F Pr(>F)

## 1 154 3148

## 2 156 3928 -2 -780 19.1 4e-08 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1screenreg(list(modelo_2, modelo_2restringido),

custom.model.names = c("Modelo 1", "Modelo 2 restringido"),

custom.coef.names = c(

"Constante", "Gasto en educación", "IED",

"Gasto en salud", "Gasto en seg. social",

"Población jóven", "Dualismo en economía",

"División étnica", "PBI pc", "Reg. democrático", "Reg. mixto",

"Reg. autoritario", "Balance entre poderes"))| Modelo 2 | Modelo 2 restringido | |

|---|---|---|

| Constante | 85.94*** | 54.43*** |

| (8.73) | (6.55) | |

| Gasto en educación | 1.59*** | 0.88 |

| (0.45) | (0.46) | |

| IED | 0.24 | 0.49* |

| (0.18) | (0.19) | |

| Gasto en salud | -0.83** | |

| (0.26) | ||

| Gasto en seg. social | -0.83*** | |

| (0.20) | ||

| Población jóven | -0.93*** | -0.28* |

| (0.17) | (0.11) | |

| Dualismo en economía | -0.17*** | -0.20*** |

| (0.03) | (0.04) | |

| División étnica | 3.68*** | 5.92*** |

| (1.04) | (1.08) | |

| PBI pc | -0.00** | -0.00 |

| (0.00) | (0.00) | |

| Reg. democrático | -2.29 | -0.77 |

| (4.75) | (5.23) | |

| Reg. mixto | -2.90 | -0.78 |

| (4.70) | (5.20) | |

| Reg. autoritario | -5.14 | -4.00 |

| (4.62) | (5.12) | |

| Balance entre poderes | -10.40*** | -7.45** |

| (2.22) | (2.40) | |

| R2 | 0.59 | 0.49 |

| Adj. R2 | 0.56 | 0.46 |

| Num. obs. | 167 | 167 |

| ***p < 0.001; **p < 0.01; *p < 0.05 | ||

Según los resultados, podemos ver que el excluir las variables del gasto en salud y en seguridad social disminuye el poder explicativo del modelo, por lo que se deberían mantener. Esto, debido a que con el comando anova se aprecia que se rechaza la hipótesis nula del test F. En la tabla se identifica que el modelo restringido tiene una bondad de ajuste menor que el modelo original, lo que implicaría que la variabilidad de la variable dependiente es explicada en menor manera que en el modelo original.

Ejercicio 5F

Antes de pasar al siguiente capítulo, haz un gráfico de dispersión de la relación entre la variable

giniy la variableinversion_extranjera. Añade el nombre del país a cada observación.

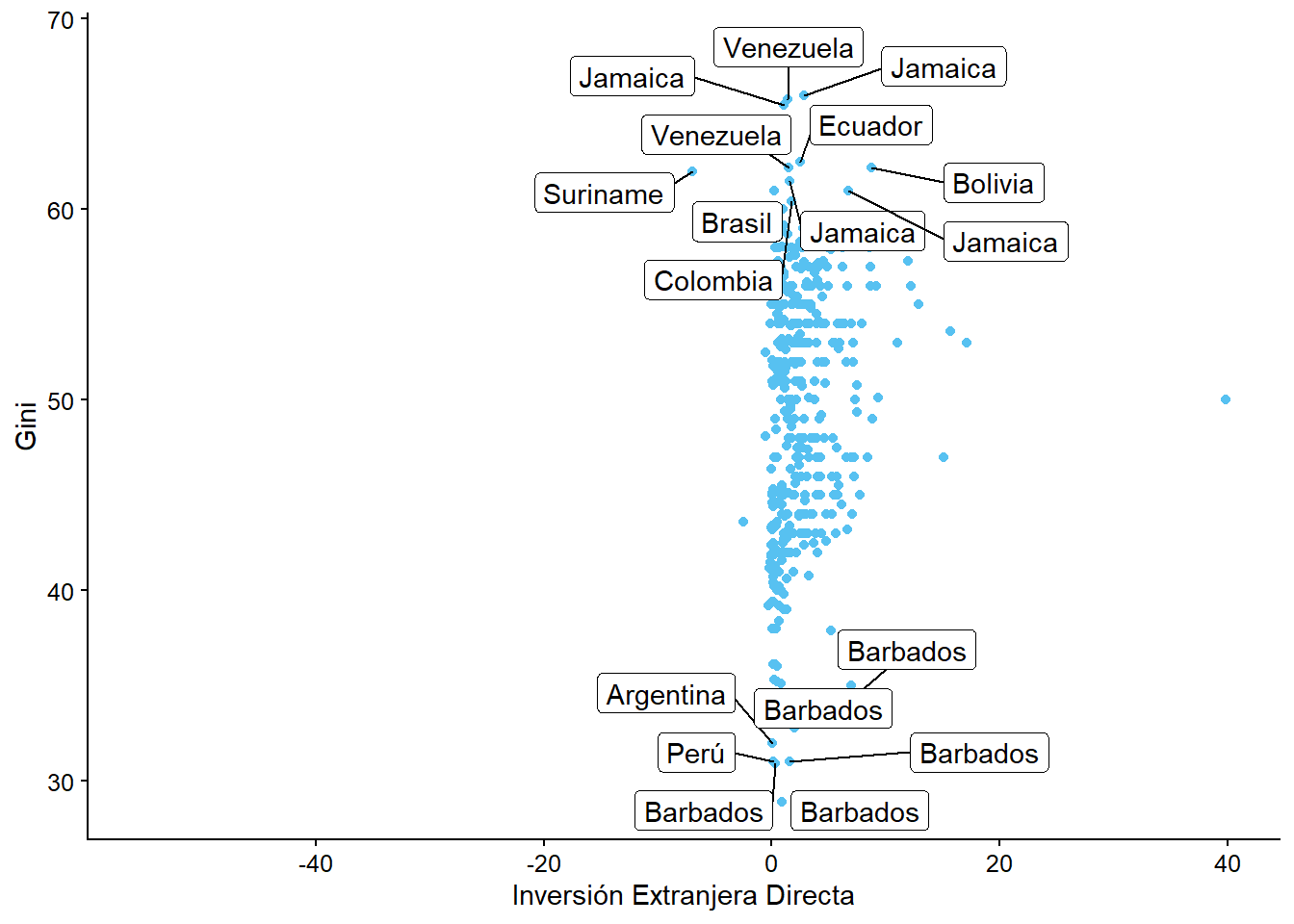

ggplot(bienestar, aes(x = inversion_extranjera, y = gini)) +

geom_point() +

labs(x = "Inversión Extranjera Directa",

y = "Gini") +

geom_label_repel(aes(label = pais))

## Warning: Removed 665 rows containing missing values (geom_point).

## Warning: Removed 665 rows containing missing values (geom_label_repel).

Podemos notar que añadir el nombre o código del país a las observaciones hace que el gráfico sea ilegible, por lo que sería mejor quedarnos con el gráfico sin etiquetas, o hacer un filtro y asignarla a algunos valores. Por ejemplo, podríamos querer ver aquellos países donde el índice de Gini es mayor a 60 y menor a 35: